Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 etapy szkolenia LLM od podstaw, jasno wyjaśnione (z wizualizacjami):

Dziś omówimy 4 etapy budowania LLM-ów od podstaw, aby uczynić je zastosowalnymi w rzeczywistych przypadkach użycia.

Omówimy:

- Wstępne szkolenie

- Dostosowanie instrukcji

- Dostosowanie preferencji

- Dostosowanie rozumowania

Wizualizacja podsumowuje te techniki.

Zanurzmy się w to!

0️⃣ Losowo zainicjowany LLM

Na tym etapie model nic nie wie.

Pytasz go „Czym jest LLM?” i otrzymujesz bełkot, taki jak „spróbuj ręki petera i cześć 448Sn”.

Nie widział jeszcze żadnych danych i posiada tylko losowe wagi.

Sprawdź to 👇

1️⃣ Wstępne szkolenie

Ten etap uczy LLM podstaw języka, trenując go na ogromnych zbiorach danych, aby przewidywał następny token. W ten sposób przyswaja gramatykę, fakty ze świata itp.

Jednak nie radzi sobie z rozmową, ponieważ po wezwaniu po prostu kontynuuje tekst.

Sprawdź to 👇

2️⃣ Dostosowywanie instrukcji

Aby uczynić to konwersacyjnym, przeprowadzamy Dostosowywanie Instrukcji, trenując na parach instrukcja-odpowiedź. Pomaga to w nauce, jak podążać za wskazówkami i formatować odpowiedzi.

Teraz potrafi:

- Odpowiadać na pytania

- Podsumowywać treści

- Pisać kod itp.

Sprawdź to 👇

Na tym etapie prawdopodobnie:

- Wykorzystaliśmy cały surowy archiwum internetu i wiedzy.

- Budżet na dane odpowiedzi instrukcji oznaczone przez ludzi.

Co możemy zrobić, aby dalej poprawić model?

Wchodzimy w obszar Uczenia przez Wzmocnienie (RL).

Uczmy się dalej 👇

3️⃣ Dostosowywanie preferencji (PFT)

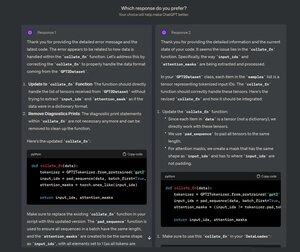

Musiałeś widzieć ten ekran w ChatGPT, na którym pytają: Którą odpowiedź preferujesz?

To nie tylko dla informacji zwrotnej, ale to cenne dane dotyczące ludzkich preferencji.

OpenAI wykorzystuje to do dostosowywania swoich modeli za pomocą dostosowywania preferencji.

Sprawdź to 👇

W PFT:

Użytkownik wybiera jedną z 2 odpowiedzi, aby uzyskać dane dotyczące preferencji ludzi.

Następnie model nagrody jest trenowany, aby przewidywać preferencje ludzi, a LLM jest aktualizowany za pomocą RL.

Sprawdź to 👇

Powyższy proces nazywa się RLHF (Uczenie przez Wzmocnienie z Ludzkim Sprzężeniem Zwrotnym), a algorytm używany do aktualizacji wag modelu nazywa się PPO.

Uczy to LLM dostosowywać się do ludzi, nawet gdy nie ma "poprawnej" odpowiedzi.

Ale możemy jeszcze bardziej poprawić LLM.

Uczmy się dalej👇

4️⃣ Udoskonalanie rozumowania

W zadaniach związanych z rozumowaniem (matematyka, logika itp.) zazwyczaj istnieje tylko jedna poprawna odpowiedź i określona seria kroków, aby uzyskać odpowiedź.

Dlatego nie potrzebujemy ludzkich preferencji i możemy użyć poprawności jako sygnału.

Nazywa się to udoskonalaniem rozumowania👇

Kroki:

- Model generuje odpowiedź na zapytanie.

- Odpowiedź jest porównywana z znaną poprawną odpowiedzią.

- Na podstawie poprawności przyznajemy nagrodę.

Nazywa się to Uczeniem Wzmocnionym z Weryfikowalnymi Nagrodami.

GRPO od DeepSeek to popularna technika.

Sprawdź to👇

To były 4 etapy szkolenia LLM od podstaw.

- Zacznij od losowo zainicjowanego modelu.

- Wstępnie wytrenuj go na korpusach na dużą skalę.

- Użyj dostrajania instrukcji, aby postępować zgodnie z poleceniami.

- Użyj precyzyjnego dostrojenia preferencji i rozumowania, aby wyostrzyć odpowiedzi.

Sprawdź to 👇

Jeśli uważasz go za wnikliwy, udostępnij go ponownie w swojej sieci.

Znajdź mnie → @_avichawla

Każdego dnia dzielę się samouczkami i spostrzeżeniami na temat DS, ML, LLM i RAGs.

21 lip 2025

4 etapy szkolenia LLM od podstaw, jasno wyjaśnione (z wizualizacjami):

@tasiorek27 Udoskonalanie przez wzmocnienie:

Udoskonalanie instrukcji: (To nie dotyczy samego szkolenia, a raczej generowania zestawu danych do udoskonalania instrukcji)

6 maj 2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,03K

Najlepsze

Ranking

Ulubione