Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 stadier av opplæring av LLM-er fra bunnen av, tydelig forklart (med bilder):

I dag dekker vi de 4 stadiene for å bygge LLM-er fra bunnen av for å gjøre dem anvendelige for virkelige brukstilfeller.

Vi dekker:

- Forberedende opplæring

- Finjustering av instruksjoner

- Finjustering av preferanser

- Resonnement finjustering

Det visuelle oppsummerer disse teknikkene.

La oss dykke inn!

0️⃣ Tilfeldig initialisert LLM

På dette tidspunktet vet modellen ingenting.

Du spør den "Hva er en LLM?" og får volapyk som "prøv peter hand og hei 448Sn".

Den har ikke sett noen data ennå og har bare tilfeldige vekter.

Sjekk dette 👇

1️⃣ Før trening

Dette stadiet lærer LLM det grunnleggende om språk ved å trene det på massive korpus for å forutsi neste token. På denne måten absorberer den grammatikk, verdensfakta osv.

Men den er ikke god i samtale fordi når den blir bedt om det, fortsetter den bare teksten.

Sjekk dette 👇

2️⃣ Instruksjon finjustering

For å gjøre det samtaleorientert, gjør vi instruksjonsfinjustering ved å trene på instruksjonsresponspar. Dette hjelper den med å lære å følge instruksjoner og formatere svar.

Nå kan den:

- Svar på spørsmål

- Oppsummer innhold

- Skriv kode osv.

Sjekk dette 👇

På dette tidspunktet har vi sannsynligvis:

- Utnyttet hele det rå internettarkivet og kunnskapen.

- Budsjettet for menneskemerkede instruksjonssvardata.

Så hva kan vi gjøre for å forbedre modellen ytterligere?

Vi går inn på territoriet til forsterkende læring (RL).

La oss lære det neste 👇

3️⃣ Preferanse finjustering (PFT)

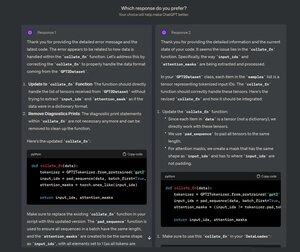

Du må ha sett denne skjermen på ChatGPT der den spør: Hvilket svar foretrekker du?

Det er ikke bare for tilbakemeldinger, men det er verdifulle menneskelige preferanser.

OpenAI bruker dette til å finjustere modellene sine ved hjelp av finjustering av preferanser.

Sjekk dette 👇

I PFT:

Brukeren velger mellom 2 svar for å produsere menneskelige preferanser.

En belønningsmodell trenes deretter til å forutsi menneskelige preferanser, og LLM oppdateres ved hjelp av RL.

Sjekk dette 👇

Prosessen ovenfor kalles RLHF (Reinforcement Learning with Human Feedback) og algoritmen som brukes til å oppdatere modellvekter kalles PPO.

Den lærer LLM å tilpasse seg mennesker selv når det ikke er noe "riktig" svar.

Men vi kan forbedre LLM enda mer.

La oss lære det neste👇

4️⃣ Resonnement finjustering

I resonneringsoppgaver (matematikk, logikk, etc.), er det vanligvis bare ett riktig svar og en definert serie trinn for å få svaret.

Så vi trenger ikke menneskelige preferanser, og vi kan bruke korrekthet som signal.

Dette kalles finjustering👇 av resonnement

Trinn:

- Modellen genererer et svar på en forespørsel.

- Svaret sammenlignes med det kjente riktige svaret.

- Basert på riktigheten tildeler vi en belønning.

Dette kalles forsterkende læring med verifiserbare belønninger.

GRPO av DeepSeek er en populær teknikk.

Sjekk dette👇

Det var de 4 stadiene for å trene en LLM fra bunnen av.

- Start med en tilfeldig initialisert modell.

- Forhåndstren den på storskala korpus.

- Bruk finjustering av instruksjoner for å få den til å følge kommandoer.

- Bruk finjustering av preferanser og resonnement for å skjerpe svarene.

Sjekk dette 👇

Hvis du syntes det var innsiktsfullt, kan du dele det på nytt med nettverket ditt.

Finn meg → @_avichawla

Hver dag deler jeg opplæringsprogrammer og innsikt om DS, ML, LLM-er og RAG-er.

21. juli 2025

4 stadier av opplæring av LLM-er fra bunnen av, tydelig forklart (med bilder):

@tasiorek27 Finjustering av forsterkning:

Instruksjonsfinjustering: (Dette handler ikke om trening i seg selv, snarere om å generere et instruksjonsfinjusteringsdatasett)

6. mai 2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,02K

Topp

Rangering

Favoritter