Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 étapes de formation des LLMs depuis le début, clairement expliquées (avec des visuels) :

Aujourd'hui, nous allons aborder les 4 étapes de la construction de LLMs (modèles de langage de grande taille) depuis le début pour les rendre applicables à des cas d'utilisation réels.

Nous allons couvrir :

- Pré-entraînement

- Affinage des instructions

- Affinage des préférences

- Affinage du raisonnement

Le visuel résume ces techniques.

Plongeons-y !

0️⃣ LLM initialisé aléatoirement

À ce stade, le modèle ne sait rien.

Vous lui demandez « Qu'est-ce qu'un LLM ? » et vous obtenez des absurdités comme « essayez peter hand et hello 448Sn ».

Il n'a pas encore vu de données et possède juste des poids aléatoires.

Vérifiez ceci 👇

1️⃣ Pré-entraînement

Cette étape enseigne à l'LLM les bases de la langue en l'entraînant sur d'énormes corpus pour prédire le prochain jeton. De cette manière, il absorbe la grammaire, des faits sur le monde, etc.

Mais il n'est pas bon en conversation car, lorsqu'on lui demande, il continue simplement le texte.

Vérifiez ceci 👇

2️⃣ Ajustement fin des instructions

Pour le rendre conversationnel, nous effectuons un ajustement fin des instructions en nous entraînant sur des paires instruction-réponse. Cela l'aide à apprendre comment suivre des instructions et formater des réponses.

Maintenant, il peut :

- Répondre à des questions

- Résumer du contenu

- Écrire du code, etc.

Vérifiez ceci 👇

À ce stade, nous avons probablement :

- Utilisé l'ensemble de l'archive internet brute et des connaissances.

- Le budget pour les données de réponse aux instructions étiquetées par des humains.

Alors, que pouvons-nous faire pour améliorer davantage le modèle ?

Nous entrons dans le domaine de l'apprentissage par renforcement (RL).

Apprenons ensuite 👇

3️⃣ Ajustement des préférences (PFT)

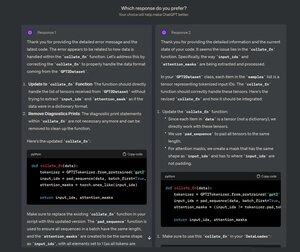

Vous avez sûrement vu cet écran sur ChatGPT où il demande : Quelle réponse préférez-vous ?

Ce n'est pas seulement pour obtenir des retours, mais c'est des données précieuses sur les préférences humaines.

OpenAI utilise cela pour affiner ses modèles grâce à l'ajustement des préférences.

Vérifiez cela 👇

Dans PFT :

L'utilisateur choisit entre 2 réponses pour produire des données de préférence humaine.

Un modèle de récompense est ensuite entraîné pour prédire la préférence humaine et le LLM est mis à jour en utilisant le RL.

Vérifiez ceci 👇

Le processus ci-dessus s'appelle RLHF (Apprentissage par Renforcement avec Retour Humain) et l'algorithme utilisé pour mettre à jour les poids du modèle s'appelle PPO.

Il enseigne au LLM de s'aligner avec les humains même lorsqu'il n'y a pas de réponse "correcte".

Mais nous pouvons améliorer encore plus le LLM.

Apprenons la suite👇

4️⃣ Ajustement de raisonnement

Dans les tâches de raisonnement (mathématiques, logique, etc.), il y a généralement une seule réponse correcte et une série d'étapes définies pour obtenir la réponse.

Donc, nous n'avons pas besoin de préférences humaines, et nous pouvons utiliser la justesse comme signal.

C'est ce qu'on appelle l'ajustement de raisonnement👇

Étapes :

- Le modèle génère une réponse à une invite.

- La réponse est comparée à la réponse correcte connue.

- En fonction de la justesse, nous attribuons une récompense.

Ceci s'appelle l'apprentissage par renforcement avec des récompenses vérifiables.

GRPO par DeepSeek est une technique populaire.

Vérifiez ceci👇

Telles étaient les 4 étapes de la formation d’un LLM à partir de zéro.

- Commencez avec un modèle initialisé de manière aléatoire.

- Pré-entraînez-le sur des corpus à grande échelle.

- Utilisez le réglage fin des instructions pour qu’il suive les commandes.

- Utilisez le réglage fin des préférences et du raisonnement pour affiner les réponses.

Vérifiez ceci 👇

Si vous l’avez trouvé perspicace, partagez-le à nouveau avec votre réseau.

Trouvez-moi → @_avichawla

Chaque jour, je partage des tutoriels et des idées sur les DS, le ML, les LLM et les RAG.

21 juil. 2025

4 étapes de formation des LLMs depuis le début, clairement expliquées (avec des visuels) :

@tasiorek27 Affinage par renforcement :

Affinage par instruction : (Il ne s'agit pas de formation à proprement parler, mais plutôt de la génération d'un ensemble de données pour l'affinage par instruction)

6 mai 2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,03K

Meilleurs

Classement

Favoris