热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

从头开始训练LLMs的4个阶段,清晰解释(附视觉图):

今天,我们将讨论从零开始构建大型语言模型(LLMs)的四个阶段,以使其适用于现实世界的用例。

我们将涵盖:

- 预训练

- 指令微调

- 偏好微调

- 推理微调

视觉图总结了这些技术。

让我们深入了解!

0️⃣ 随机初始化的 LLM

此时,模型一无所知。

你问它“什么是 LLM?”它却给出像“试试彼得手和你好 448Sn”这样的无意义回答。

它还没有看到任何数据,仅仅拥有随机权重。

查看这个 👇

1️⃣ 预训练

这个阶段通过在大量语料库上进行训练,教会LLM语言的基础知识,以预测下一个标记。这样,它吸收了语法、世界事实等。

但它在对话方面表现不佳,因为当被提示时,它只是继续文本。

查看这个 👇

2️⃣ 指令微调

为了使其具有对话性,我们通过训练指令-响应对进行指令微调。这有助于它学习如何遵循提示并格式化回复。

现在它可以:

- 回答问题

- 总结内容

- 编写代码等。

查看这个 👇

在这一点上,我们可能已经:

- 利用整个原始互联网档案和知识。

- 为人工标记的指令响应数据分配了预算。

那么我们可以做些什么来进一步改善模型呢?

我们进入了强化学习(RL)的领域。

接下来让我们学习 👇

3️⃣ 偏好微调(PFT)

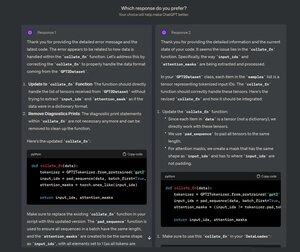

你一定见过ChatGPT上的这个界面,它会问:你更喜欢哪个回答?

这不仅仅是为了反馈,而是宝贵的人类偏好数据。

OpenAI利用这些数据来通过偏好微调来优化他们的模型。

查看这个 👇

在PFT中:

用户在两个响应之间选择,以生成人类偏好数据。

然后训练一个奖励模型来预测人类偏好,并使用强化学习更新LLM。

查看这个👇

上述过程称为RLHF(带有人类反馈的强化学习),用于更新模型权重的算法称为PPO。

它教会LLM与人类对齐,即使没有“正确”的答案。

但我们可以进一步改善LLM。

接下来让我们学习👇

4️⃣ 推理微调

在推理任务(数学、逻辑等)中,通常只有一个正确的答案和一系列明确的步骤来获得答案。

因此,我们不需要人类的偏好,可以使用正确性作为信号。

这被称为推理微调👇

步骤:

- 模型生成对提示的回答。

- 将回答与已知的正确答案进行比较。

- 根据正确性,我们分配奖励。

这被称为可验证奖励的强化学习。

DeepSeek 的 GRPO 是一种流行的技术。

查看这个👇

这些是从头开始训练法学硕士的 4 个阶段。

- 从随机初始化的模型开始。

- 在大规模语料库上对其进行预训练。

- 使用指令微调使其遵循命令。

- 使用偏好和推理微调来提高响应能力。

检查这个 👇

如果你觉得这很有启发性,请与您的网络分享。

找到我 → @_avichawla

每天,我都会分享关于数据科学、机器学习、大型语言模型和检索增强生成的教程和见解。

2025年7月21日

从头开始训练LLMs的4个阶段,清晰解释(附视觉图):

@tasiorek27 强化微调:

指令微调:(这并不是关于训练本身,而是关于生成一个指令微调数据集)

2025年5月6日

Let's generate our own LLM fine-tuning dataset (100% local):

714.03K

热门

排行

收藏