Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 giai đoạn đào tạo LLM từ đầu, được giải thích rõ ràng (có hình ảnh):

Hôm nay, chúng ta sẽ đề cập đến 4 giai đoạn xây dựng LLM từ đầu để làm cho chúng có thể áp dụng cho các trường hợp sử dụng trong thế giới thực.

Chúng ta sẽ đề cập đến:

- Huấn luyện trước

- Tinh chỉnh hướng dẫn

- Tinh chỉnh sở thích

- Tinh chỉnh lý luận

Hình ảnh tóm tắt những kỹ thuật này.

Hãy cùng khám phá!

0️⃣ LLM được khởi tạo ngẫu nhiên

Tại thời điểm này, mô hình không biết gì cả.

Bạn hỏi nó "LLM là gì?" và nhận được những câu vô nghĩa như "thử tay peter và xin chào 448Sn".

Nó chưa thấy bất kỳ dữ liệu nào và chỉ có những trọng số ngẫu nhiên.

Kiểm tra điều này 👇

1️⃣ Huấn luyện trước

Giai đoạn này dạy cho LLM những kiến thức cơ bản về ngôn ngữ bằng cách đào tạo nó trên các tập dữ liệu khổng lồ để dự đoán token tiếp theo. Bằng cách này, nó hấp thụ ngữ pháp, sự thật về thế giới, v.v.

Nhưng nó không giỏi trong việc trò chuyện vì khi được yêu cầu, nó chỉ tiếp tục văn bản.

2️⃣ Hướng dẫn tinh chỉnh

Để làm cho nó trở nên hội thoại, chúng tôi thực hiện Tinh chỉnh Hướng dẫn bằng cách đào tạo trên các cặp hướng dẫn-phản hồi. Điều này giúp nó học cách theo dõi các yêu cầu và định dạng câu trả lời.

Bây giờ nó có thể:

- Trả lời câu hỏi

- Tóm tắt nội dung

- Viết mã, v.v.

Kiểm tra điều này 👇

Tại thời điểm này, chúng ta có thể đã:

- Sử dụng toàn bộ kho lưu trữ internet thô và kiến thức.

- Ngân sách cho dữ liệu phản hồi hướng dẫn được gán nhãn bởi con người.

Vậy chúng ta có thể làm gì để cải thiện mô hình hơn nữa?

Chúng ta bước vào lãnh thổ của Học Tăng Cường (RL).

Hãy cùng học tiếp nào 👇

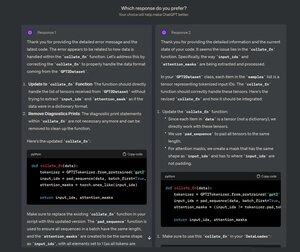

3️⃣ Tinh chỉnh sở thích (PFT)

Bạn chắc hẳn đã thấy màn hình này trên ChatGPT, nơi nó hỏi: Bạn thích phản hồi nào hơn?

Điều đó không chỉ để lấy phản hồi mà còn là dữ liệu sở thích của con người rất quý giá.

OpenAI sử dụng điều này để tinh chỉnh các mô hình của họ thông qua việc tinh chỉnh sở thích.

Kiểm tra điều này 👇

Trong PFT:

Người dùng chọn giữa 2 phản hồi để tạo ra dữ liệu sở thích của con người.

Một mô hình thưởng sau đó được huấn luyện để dự đoán sở thích của con người và LLM được cập nhật bằng cách sử dụng RL.

Kiểm tra cái này 👇

Quá trình trên được gọi là RLHF (Học Tăng Cường với Phản Hồi của Con Người) và thuật toán được sử dụng để cập nhật trọng số mô hình được gọi là PPO.

Nó dạy cho LLM cách phù hợp với con người ngay cả khi không có câu trả lời "đúng".

Nhưng chúng ta có thể cải thiện LLM còn hơn nữa.

Hãy cùng học tiếp👇

4️⃣ Tinh chỉnh lý luận

Trong các nhiệm vụ lý luận (toán học, logic, v.v.), thường chỉ có một phản hồi đúng và một chuỗi các bước xác định để đạt được câu trả lời.

Vì vậy, chúng ta không cần sở thích của con người, và chúng ta có thể sử dụng độ chính xác làm tín hiệu.

Điều này được gọi là tinh chỉnh lý luận👇

Các bước:

- Mô hình tạo ra một câu trả lời cho một yêu cầu.

- Câu trả lời được so sánh với câu trả lời đúng đã biết.

- Dựa trên độ chính xác, chúng tôi sẽ gán một phần thưởng.

Điều này được gọi là Học Tăng Cường với Phần Thưởng Có Thể Xác Minh.

GRPO của DeepSeek là một kỹ thuật phổ biến.

Kiểm tra điều này👇

Đó là 4 giai đoạn đào tạo LLM từ đầu.

- Bắt đầu với một mô hình được khởi tạo ngẫu nhiên.

- Đào tạo trước nó trên kho dữ liệu quy mô lớn.

- Sử dụng tinh chỉnh hướng dẫn để làm cho nó tuân theo các lệnh.

- Sử dụng tinh chỉnh sở thích và lý luận để làm sắc nét các câu trả lời.

Kiểm tra cái này 👇

Nếu bạn thấy nó hữu ích, hãy chia sẻ lại với mạng lưới của bạn.

Tìm tôi → @_avichawla

Mỗi ngày, tôi chia sẻ các hướng dẫn và thông tin về DS, ML, LLMs và RAGs.

21 thg 7, 2025

4 giai đoạn đào tạo LLM từ đầu, được giải thích rõ ràng (có hình ảnh):

@tasiorek27 Tinh chỉnh tăng cường:

Tinh chỉnh hướng dẫn: (Điều này không phải là về việc đào tạo mà chủ yếu là về việc tạo ra một tập dữ liệu tinh chỉnh hướng dẫn)

6 thg 5, 2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,03K

Hàng đầu

Thứ hạng

Yêu thích