Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 etape de formare a LLM-urilor de la zero, explicate clar (cu imagini):

Astăzi, acoperim cele 4 etape ale construirii LLM-urilor de la zero pentru a le face aplicabile pentru cazurile de utilizare din lumea reală.

Vom acoperi:

- Pre-instruire

- Reglarea fină a instrucțiunilor

- Reglarea fină a preferințelor

- Reglarea fină a raționamentului

Vizualul rezumă aceste tehnici.

Să ne scufundăm!

0️⃣ LLM inițializat aleatoriu

În acest moment, modelul nu știe nimic.

Îl întrebi "Ce este un LLM?" și devii fără sens ca "încearcă mâna lui Peter și salut 448Sn".

Nu a văzut încă date și posedă doar greutăți aleatorii.

Verificați acest lucru 👇

1️⃣ Pre-antrenament

Această etapă îl învață pe LLM elementele de bază ale limbajului, antrenându-l pe corpus masiv pentru a prezice următorul token. În acest fel, absoarbe gramatica, faptele lumii etc.

Dar nu este bun la conversație pentru că atunci când i se cere, continuă textul.

Verificați acest lucru 👇

2️⃣ Reglarea fină a instrucțiunilor

Pentru a-l face conversațional, facem reglarea fină a instrucțiunilor prin antrenament pe perechi instrucție-răspuns. Acest lucru îl ajută să învețe cum să urmeze instrucțiunile și să formateze răspunsurile.

Acum poate:

- Răspundeți la întrebări

- Rezumați conținutul

- Scrieți cod etc.

Verificați acest lucru 👇

În acest moment, probabil avem:

- A utilizat întreaga arhivă și cunoștințe brute de pe internet.

- Bugetul pentru datele de răspuns la instrucțiuni etichetate de om.

Deci, ce putem face pentru a îmbunătăți și mai mult modelul?

Intrăm pe teritoriul Reinforcement Learning (RL).

Să învățăm în continuare 👇

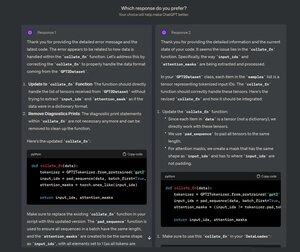

3️⃣ Reglarea fină a preferințelor (PFT)

Trebuie să fi văzut acest ecran pe ChatGPT unde întreabă: Ce răspuns preferați?

Asta nu este doar pentru feedback, ci sunt date valoroase despre preferințele umane.

OpenAI folosește acest lucru pentru a-și regla modelele folosind reglarea fină a preferințelor.

Verificați acest lucru 👇

În PFT:

Utilizatorul alege între 2 răspunsuri pentru a produce date despre preferințele umane.

Un model de recompensă este apoi antrenat pentru a prezice preferințele umane și LLM este actualizat folosind RL.

Verificați acest lucru 👇

Procesul de mai sus se numește RLHF (Reinforcement Learning with Human Feedback), iar algoritmul folosit pentru a actualiza greutățile modelului se numește PPO.

Învață LLM să se alinieze cu oamenii chiar și atunci când nu există un răspuns "corect".

Dar putem îmbunătăți și mai mult LLM.

Să învățăm în continuare👇

4️⃣ Reglarea fină a raționamentului

În sarcinile de raționament (matematică, logică etc.), există de obicei un singur răspuns corect și o serie definită de pași pentru a obține răspunsul.

Deci nu avem nevoie de preferințele umane și putem folosi corectitudinea ca semnal.

Aceasta se numește reglare👇 fină a raționamentului

Paşi:

- Modelul generează un răspuns la o solicitare.

- Răspunsul este comparat cu răspunsul corect cunoscut.

- Pe baza corectitudinii, atribuim o recompensă.

Aceasta se numește învățare prin întărire cu recompense verificabile.

GRPO de la DeepSeek este o tehnică populară.

Verificați acest lucru👇

Acestea au fost cele 4 etape ale pregătirii unui LLM de la zero.

- Începeți cu un model inițializat aleatoriu.

- Antrenează-l în prealabil pe corpus la scară largă.

- Utilizați reglarea fină a instrucțiunilor pentru a-l face să urmeze comenzi.

- Utilizați reglarea fină a preferințelor și raționamentului pentru a clarifica răspunsurile.

Verificați acest lucru 👇

Dacă ți s-a părut util, redistribui-l rețelei tale.

Găsește-mă → @_avichawla

În fiecare zi, împărtășesc tutoriale și informații despre DS, ML, LLM-uri și RAG.

21 iul. 2025

4 etape de formare a LLM-urilor de la zero, explicate clar (cu imagini):

@tasiorek27 Reglarea fină a armăturii:

Reglarea fină a instrucțiunilor: (Nu este vorba despre antrenament în sine, ci mai degrabă despre generarea unui set de date de reglare fină a instrucțiunilor)

6 mai 2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,04K

Limită superioară

Clasament

Favorite