Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 etapas de treino de LLMs desde o início, claramente explicadas (com visuais):

Hoje, vamos abordar as 4 etapas de construção de LLMs do zero para torná-las aplicáveis a casos de uso do mundo real.

Vamos cobrir:

- Pré-treinamento

- Ajuste fino de instruções

- Ajuste fino de preferências

- Ajuste fino de raciocínio

A visualização resume essas técnicas.

Vamos mergulhar!

0️⃣ LLM inicializado aleatoriamente

Neste ponto, o modelo não sabe nada.

Você pergunta “O que é um LLM?” e recebe um monte de palavras sem sentido como “tente a mão de peter e olá 448Sn”.

Ele ainda não viu nenhum dado e possui apenas pesos aleatórios.

Verifique isto 👇

1️⃣ Pré-treinamento

Esta fase ensina ao LLM os fundamentos da linguagem, treinando-o em corpora massivos para prever o próximo token. Desta forma, ele absorve gramática, fatos do mundo, etc.

Mas não é bom em conversação porque, quando solicitado, apenas continua o texto.

Veja isto 👇

2️⃣ Ajuste fino de instruções

Para torná-lo conversacional, fazemos o Ajuste Fino de Instruções treinando em pares de instrução-resposta. Isso ajuda a aprender como seguir os prompts e formatar as respostas.

Agora ele pode:

- Responder a perguntas

- Resumir conteúdo

- Escrever código, etc.

Verifique isto 👇

Neste ponto, provavelmente temos:

- Utilizado todo o arquivo bruto da internet e conhecimento.

- O orçamento para dados de resposta a instruções rotulados por humanos.

Então, o que podemos fazer para melhorar ainda mais o modelo?

Entramos no território do Aprendizado por Reforço (RL).

Vamos aprender a seguir 👇

3️⃣ Ajuste fino de preferências (PFT)

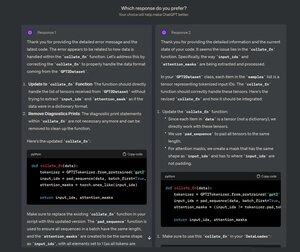

Você deve ter visto esta tela no ChatGPT onde pergunta: Qual resposta você prefere?

Isso não é apenas para feedback, mas é um dado valioso sobre preferências humanas.

A OpenAI usa isso para ajustar seus modelos usando o ajuste fino de preferências.

Confira isto 👇

Em PFT:

O utilizador escolhe entre 2 respostas para produzir dados de preferência humana.

Um modelo de recompensa é então treinado para prever a preferência humana e o LLM é atualizado usando RL.

Verifique isto 👇

O processo acima é chamado RLHF (Aprendizagem por Reforço com Feedback Humano) e o algoritmo utilizado para atualizar os pesos do modelo é chamado PPO.

Ele ensina o LLM a alinhar-se com os humanos mesmo quando não há uma resposta "correta".

Mas podemos melhorar ainda mais o LLM.

Vamos aprender a seguir👇

4️⃣ Ajuste fino do raciocínio

Em tarefas de raciocínio (matemática, lógica, etc.), geralmente há apenas uma resposta correta e uma série definida de passos para obter a resposta.

Portanto, não precisamos de preferências humanas, e podemos usar a correção como sinal.

Isto é chamado de ajuste fino do raciocínio👇

Passos:

- O modelo gera uma resposta a um prompt.

- A resposta é comparada com a resposta correta conhecida.

- Com base na correção, atribuímos uma recompensa.

Isto é chamado de Aprendizagem por Reforço com Recompensas Verificáveis.

GRPO da DeepSeek é uma técnica popular.

Verifique isto👇

Essas foram as 4 etapas de treinamento de um LLM do zero.

- Comece com um modelo inicializado aleatoriamente.

- Pré-treiná-lo em corpora de grande escala.

- Use instruções de ajuste fino para fazê-lo seguir comandos.

- Use preferência e ajuste fino de raciocínio para afiar as respostas.

Confira: 👇

Se você achou interessante, compartilhe novamente com sua rede.

Encontre-me → @_avichawla

Todos os dias, compartilho tutoriais e insights sobre DS, ML, LLMs e RAGs.

21/07/2025

4 etapas de treino de LLMs desde o início, claramente explicadas (com visuais):

@tasiorek27 Ajuste fino de reforço:

Ajuste fino de instruções: (Isto não se trata de treino propriamente dito, mas sim de gerar um conjunto de dados para ajuste fino de instruções)

6/05/2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,04K

Top

Classificação

Favoritos