Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 етапи навчання ЛМ з нуля, наочно пояснені (з наочністю):

Сьогодні ми розглянемо 4 етапи створення LLM з нуля, щоб зробити їх придатними для реальних випадків використання.

Ми розглянемо:

- Попередня підготовка

- Інструкція з тонкої настройки

- Тонка настройка переваг

- Тонка настройка міркувань

Наочний матеріал узагальнює ці прийоми.

Давайте зануримося!

0️⃣ Випадково ініціалізований LLM

На даний момент модель нічого не знає.

Ви питаєте його: «Що таке LLM?» і отримуєте тарабарщину на кшталт «спробуйте пітер хенд і привіт 448Sn».

Він ще не бачив жодних даних і має лише випадкові ваги.

Перевірте це 👇

1️⃣ Попередня підготовка

Цей етап навчає LLM основам мови, тренуючи його на масивних корпусах для прогнозування наступного токена. Таким чином, він вбирає граматику, факти світу тощо.

Але він не дуже добре вміє розмовляти, тому що коли його запитують, він просто продовжує текст.

Перевірте це 👇

2️⃣ Інструкція з тонкої настройки

Щоб зробити його розмовним, ми проводимо тонке налаштування інструкцій, тренуючись на парах інструкція-відповідь. Це допомагає йому навчитися слідувати підказкам і форматувати відповіді.

Тепер він може:

- Відповідайте на запитання

- Узагальнити зміст

- Писати код і т.д.

Перевірте це 👇

На даний момент ми, ймовірно, маємо:

- Використано весь необроблений інтернет-архів та знання.

- Бюджет на дані відповідей на інструкції, позначені людиною.

Отже, що ми можемо зробити для подальшого вдосконалення моделі?

Ми входимо на територію навчання з підкріпленням (РЛ).

Давайте дізнаємося далі 👇

3️⃣ Тонке налаштування параметрів (PFT)

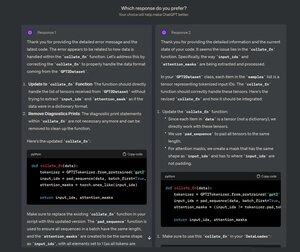

Ви, мабуть, бачили цей екран на ChatGPT, де він запитує: Якій відповіді ви віддаєте перевагу?

Це не лише для зворотного зв'язку, але й для цінних даних про людські вподобання.

OpenAI використовує це для точного налаштування своїх моделей за допомогою тонкого налаштування параметрів.

Перевірте це 👇

У ПФТ:

Користувач вибирає між 2 відповідями, щоб отримати дані про людські переваги.

Потім модель винагороди навчається передбачати людські переваги, а LLM оновлюється за допомогою RL.

Перевірте це 👇

Вищезазначений процес називається RLHF (Reinforcement Learning with Human Feedback), а алгоритм, який використовується для оновлення ваг моделі, називається PPO.

Це вчить LLM узгоджуватися з людьми навіть тоді, коли немає «правильної» відповіді.

Але ми можемо вдосконалити LLM ще більше.

Давайте дізнаємося далі👇

4️⃣ Тонка настройка міркувань

У завданнях на міркування (математика, логіка тощо) зазвичай є лише одна правильна відповідь і визначений ряд кроків для отримання відповіді.

Таким чином, нам не потрібні людські уподобання, і ми можемо використовувати правильність як сигнал.

Це називається тонкою настройкою👇 міркувань

Кроки:

- Модель генерує відповідь на запит.

- Відповідь порівнюється з відомо правильною відповіддю.

- Виходячи з правильності, ми призначаємо винагороду.

Це називається навчанням з підкріпленням з перевіреними винагородами.

GRPO від DeepSeek – популярна техніка.

Перевірте це👇

Це були 4 етапи навчання LLM з нуля.

- Почніть з випадково ініціалізованої моделі.

- Попередньо проведіть тренування на великих корпусах.

- Використовуйте тонке налаштування інструкцій, щоб змусити його виконувати команди.

- Використовуйте тонке налаштування уподобань і міркувань, щоб загострити відповіді.

Перевірте це 👇

Якщо ви вважаєте її зрозумілою, повторно поділіться нею зі своєю мережею.

Знайди мене → @_avichawla

Щодня я ділюся навчальними матеріалами та ідеями про DS, ML, LLM та RAG.

21 лип. 2025 р.

4 етапи навчання ЛМ з нуля, наочно пояснені (з наочністю):

@tasiorek27 Тонка настройка арматури:

Тонке налаштування інструкцій: (Мова йде не про навчання як таке, а про створення набору даних для тонкого налаштування інструкцій)

6 трав. 2025 р.

Let's generate our own LLM fine-tuning dataset (100% local):

714,02K

Найкращі

Рейтинг

Вибране