Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Fall i et oksemarked er ment å kjøpes, spesielt på prosjekter med store katalysatorer

Vi vet alle at AI er fortellingen om denne syklusen, startet av ai16z og Virtuals i fjor.

Min innsats er at markedet vil fokusere på mer komplekse og sofistikerte teknologier som VLA-er, og la meg fortelle deg hvorfor.

LLM-er (Large Language Models) leser og skriver hovedsakelig tekst: de er flinke til å forklare, planlegge og generere instruksjoner, men de styrer ikke i seg selv motorer eller samhandler med den fysiske verden (som du kanskje har opplevd med chatgpt).

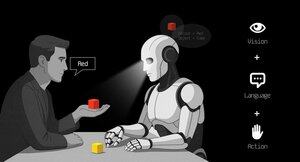

VLA-er (Vision Language Action-modeller) skiller seg fra LLM-er ettersom de er multimodale systemer som ser på ting (syn), forstår instruksjoner (språk) og direkte produserer handlinger. Det er som å be en robot om å plukke opp en rød kopp og deretter bevege armen for å gjøre det.

VLA-er er trent på eksempler som parer bilder/video + instruksjoner + virkelige handlingsspor (hvordan en robot faktisk beveget seg), og de må løpe raskt og trygt i sanntid. LLM-er på sin side er opplært på enorme tekstsamlinger og fokuserer på resonnement og språkoppgaver.

TL; DR LLM-er tenker og snakker når VLA-er ser, resonnerer og handler.

Som du kan se, er VLA-er et viktig tillegg til LLM-er og vil spesielt muliggjøre den neste 0 til 1-innovasjonen i den totale økonomien som vil være robotikk. Et flertall av investeringsfondene allokerer en stor del av investeringene sine til denne sektoren, sett på som den neste logiske utviklingen i AI-industrien.

Jeg har allerede laget et innlegg for en stund siden om den nåværende lederen i kryptomarkedet, @codecopenflow, som ikke samlet inn kapital (rettferdig lansering), men som likevel sender banebrytende produkter og for tiden ligger på 23 millioner dollar FDV.

For informasjon samlet andre kryptokonkurrenter inn 20 millioner dollar (@openmind_agi) til det som sannsynligvis er en FDV på 200 til 300 millioner dollar ++ mens ingen produkter eller fellesskap er bygget og sendt ennå.

Det som gjør Codec til et ledende prosjekt i sektoren er at de takler en avgjørende flaskehals innen robotikk og AI, som er vanskeligheten med å få alle AI-verktøyene til å samhandle sammen. La meg forklare.

Deres siste utgivelse, OPTR (operator), er et verktøysett som hjelper til med å bygge operatører som er i stand til å samhandle på flere plattformer som roboter, stasjonære datamaskiner, nettlesere eller simuleringer. Målet til en operatør er å se, resonnere og handle (VLA) i både digitale (datamaskiner) og fysiske (roboter) verdener.

Dette verktøysettet fungerer som kjerneinfrastruktur for robotteam som tar sikte på å teste produktet sitt og forbedre den generelle prosessen ved å gi en enhetlig opplevelse i stedet for separate for nettlesere, simuleringer eller roboter. Dette gjør i hovedsak operatøren tilpasningsdyktig og autonom uavhengig av omgivelsene.

Så du skjønner det, det vil spare mye tid for selskaper og utviklere som tidligere måtte gå gjennom hvert trinn manuelt, og hvor du kan spare tid kan du spare penger.

Det vil også gjøre det mulig for Codec å bygge sine egne operatørprosjekter og lansere nye kapasiteter relativt raskt på markedet, spesielt gjennom deres markedsplass.

TL; DR: Du har sikkert sett videoer av roboter som bretter vev, sorterer bokser eller hopper på forskjellige elementer. De har alle fått opplæring for dette svært spesifikke brukstilfellet, og dessverre kan ikke en ferdighet gjenbrukes i et annet miljø slik et menneske kan gjøre. OPTR fra Codec løser dette ved å gjøre ferdigheter overførbare mellom miljøer og situasjoner, noe som gjør opplæring og utvikling mye raskere og billigere for bedrifter.

Dette er grunnen til at Codec er så interessant for å forene den digitale verden med den fysiske verden.

$CODEC, kodet.

7,24K

Topp

Rangering

Favoritter