Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zde je tento týden Ritual Research Digest, zpravodaj pokrývající nejnovější ve světě LLM a průnik Crypto x AI.

Se stovkami novin publikovaných týdně je nemožné mít přehled o těch nejnovějších. Provedeme čtení, abyste vy nemuseli.

Vícemodulové GRPO: Skládání gradientů politik a optimalizace promptů pro programy jazykových modelů

Tento článek zkoumá, zda lze post-trénování použít na rámce rychlé optimalizace.

Jedná se o první implementaci GRPO do komplexních LLM pipelines. Metoda MM-GRPO zlepšuje výkon v průměru o 7 % oproti vanilkovému CoT. I když ne vždy překoná rychlou optimalizaci, je to vždy účinný kompliment.

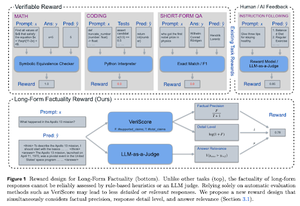

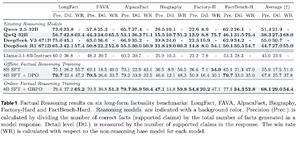

Naučit se uvažovat pro faktičnost

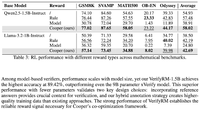

Tento článek vyvíjí funkci odměny za trénink dlouhého CoT (Chain of Thought) pro faktičnost. Jejich design odměňuje hackování tím, že upřednostňuje přesnost, detaily a kvalitu zároveň.

Zjistili, že jejich funkce odměňování v RL překonává základní model (Llama-3.1-8B-Instruct) ve všech metrikách v několika datových sadách. Stávající LLM (QwQ, R1) trpí poklesem faktičnosti ve srovnání s jejich základním modelem (Qwen 2.5 32B, DS v3).

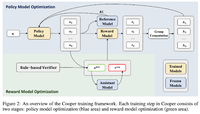

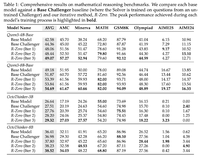

Cooper: Společná optimalizace modelů zásad a odměňování v posilovaném učení pro velké jazykové modely

V tomto článku navrhují metodu RL, Cooperovu metodu, která trénuje model politiky a model odměňování současně.

Vydávají datovou sadu pro modelování odměn, která je označena pomocí strategie, která kombinuje ověřování na základě pravidel a ověřování LLM-as-a-judge. Zjistili, že dynamická úprava modelu odměn během RL může účinně zmírnit hackování odměn.

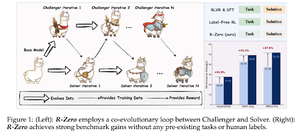

R-Zero: Samo-vyvíjející se uvažování LLM z nulových dat

V tomto článku navrhují R-Zero pro trénování LLM uvažování, které se mohou samy vyvinout z 0 externích dat. Stejný model je inicializován se dvěma rolemi (vyzyvatel/řešitel), které se společně vyvíjejí v RL.

Vyzyvatel je odměňován za generování úkolů, které jsou pro současné schopnosti Řešitele obtížné, zatímco Řešitel je odměňován za řešení těchto stále obtížnějších úkolů, které představuje Vyzyvatel. R-Zero je modelově agnostický rámec a vykazuje výhody oproti modelu Qwen3-4b.

Představují také CompassVerifier, rodinu robustních verifikačních modelů. Trénováno s daty z původní lavice, daty vylepšenými vzorci a daty o halucinacích. Jejich model funguje lépe než jiné modely jako řada Qwen2.5 a 3 a je užitečný i jako model za odměnu.

Sledujte nás @ritualdigest pro více informací o všem, co se týká výzkumu Crypto x AI, a @ritualnet se dozvíte více o tom, co Ritual buduje.

4,19K

Top

Hodnocení

Oblíbené