Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ось Ritual Research Digest цього тижня, інформаційний бюлетень, який висвітлює найновіші у світі LLM та перетин Crypto x AI.

З сотнями газет, що публікуються щотижня, залишатися в курсі останніх неможливо. Ми прочитаємо так, щоб вам не довелося.

Multi-module GRPO: складання градієнтів політик та оперативна оптимізація для програм мовних моделей

У цій статті досліджується, чи можна застосувати пост-тренінг для швидкої оптимізації.

Це перше впровадження GRPO на складні конвеєри LLM. Метод MM-GRPO покращує продуктивність в середньому на 7% у порівнянні з ванільним CoT. Хоча це не завжди перевершує оперативну оптимізацію, це завжди ефективний комплімент.

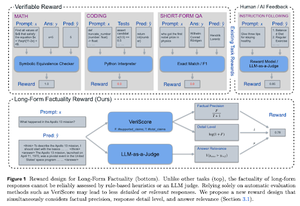

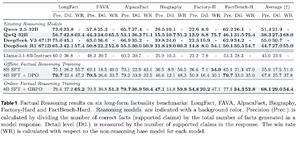

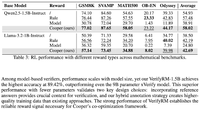

Вчимося обґрунтовувати факти

У цій статті розроблена функція винагороди за тренування довгого CoT (Chain of Thought) за фактичність. Їх дизайн запобігає хакерству, віддаючи перевагу точності, деталізації та якості одночасно.

Вони виявили, що їхня функція винагороди в RL перевершує базову модель (Llama-3.1-8B-Instruct) за всіма показниками в декількох наборах даних. Існуючі LLM міркувань (QwQ, R1) страждають від зниження фактичності в порівнянні з їх базовою моделлю (Qwen 2.5 32B, DS v3).

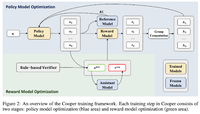

Купер: спільна оптимізація політик і моделей винагород у навчанні з підкріпленням для великих мовних моделей

У цій роботі вони пропонують метод РЛ, Купера, який тренує модель політики і модель винагороди одночасно.

Вони випускають набір даних моделювання винагород, який позначений за допомогою стратегії, що поєднує перевірку на основі правил і LLM-as-a-judge. Вони виявили, що динамічне коригування моделі винагороди під час RL може ефективно пом'якшити хакерські атаки.

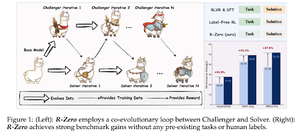

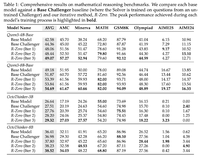

R-Zero: самоеволюційне міркування LLM на основі нульових даних

У цій роботі вони пропонують R-Zero для навчання LLM міркувань, які можуть самоеволюціонувати з 0 зовнішніх даних. Одна і та ж модель ініціалізується двома ролями (Challenger/Solver), які спільно розвиваються в RL.

Претендент отримує винагороду за створення завдань, які є важкими для поточних здібностей Розв'язувача, тоді як Розв'язувач отримує винагороду за вирішення цих дедалі складніших завдань, поставлених Челленджером. R-Zero — це незалежна від моделі структура, і вони демонструють виграш на моделі Qwen3-4b.

Вони також представляють CompassVerifier – сімейство надійних моделей верифікації. Тренується з даними з оригінальної лави, розширеними формулами даними та даними про галюцинації. Їхня модель працює краще, ніж інші моделі, такі як Qwen2.5 & series &, також корисна як модель винагороди.

Слідкуйте за нами @ritualdigest, щоб дізнатися більше про дослідження Crypto x AI, а @ritualnet дізнатися більше про те, що створює Ritual.

4,41K

Найкращі

Рейтинг

Вибране