Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Oto najnowszy Digest Ritual Research, newsletter obejmujący najnowsze wydarzenia w świecie LLM-ów oraz na styku Crypto x AI.

Z setkami publikacji co tydzień, niemożliwe jest nadążanie za nowinkami. My przeczytamy, abyś nie musiał.

Multi-Module GRPO: Kompozycja gradientów polityki i optymalizacja podpowiedzi dla programów modeli językowych

Niniejszy artykuł bada, czy po treningu można zastosować ramy optymalizacji podpowiedzi.

To jest pierwsza implementacja GRPO w złożonych pipeline'ach LLM. Metoda MM-GRPO poprawia wydajność średnio o 7% w porównaniu do standardowego CoT. Chociaż nie zawsze przewyższa optymalizację promptów, zawsze jest skutecznym uzupełnieniem.

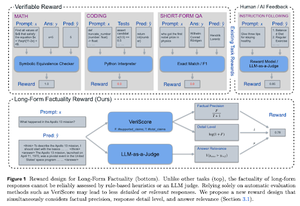

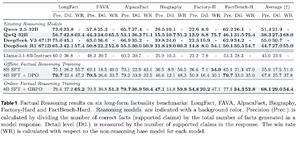

Uczenie się rozumowania dla faktualności

Niniejszy artykuł opracowuje funkcję nagrody do trenowania długiego CoT (łańcucha myśli) w celu zapewnienia faktualności. Ich projekt zapobiega manipulacji nagrodami, faworyzując jednocześnie precyzję, szczegóły i jakość.

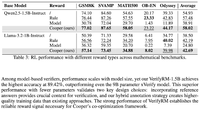

Stwierdzają, że ich funkcja nagrody w RL przewyższa model bazowy (Llama-3.1-8B-Instruct) we wszystkich metrykach w różnych zbiorach danych. Istniejące modele LLM do rozumowania (QwQ, R1) cierpią na spadek faktualności w porównaniu do swojego modelu bazowego (Qwen 2.5 32B, DS v3).

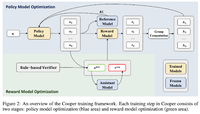

Cooper: Współoptymalizacja modeli polityki i nagród w uczeniu przez wzmocnienie dla dużych modeli językowych

W tym artykule proponują metodę RL, Cooper, która jednocześnie trenuje model polityki i model nagród.

Wydają zestaw danych do modelowania nagród, który jest oznaczony przy użyciu strategii łączącej weryfikację opartą na regułach i LLM jako sędzia. Odkrywają, że dynamiczne dostosowywanie modelu nagród podczas RL może skutecznie łagodzić problemy z manipulowaniem nagrodami.

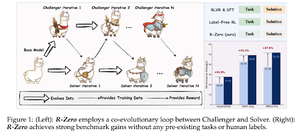

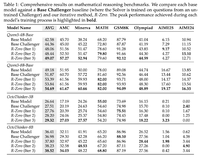

R-Zero: Samoewoluujący model reasoning LLM z zerowymi danymi

W tym artykule proponują R-Zero do trenowania reasoning LLM, które mogą samoewoluować z 0 zewnętrznych danych. Ten sam model jest inicjowany z dwoma rolami (Challenger/Solver), które współewoluują w RL.

Challenger jest nagradzany za generowanie zadań, które są trudne dla obecnych umiejętności Solver'a, podczas gdy Solver jest nagradzany za rozwiązywanie tych coraz trudniejszych zadań stawianych przez Challenger'a. R-Zero to model-agnostyczna struktura, a oni pokazują zyski na modelu Qwen3-4b.

Prezentują również CompassVerifier, rodzinę solidnych modeli weryfikacyjnych. Wytrenowane na danych z oryginalnej ławki, danych wzbogaconych formułami i danych dotyczących halucynacji. Ich model działa lepiej niż inne modele, takie jak Qwen2.5 i seria 3, i jest pomocny jako model nagród.

Śledź nas @ritualdigest, aby uzyskać więcej informacji na temat wszystkiego, co związane z badaniami Crypto x AI, oraz @ritualnet, aby dowiedzieć się więcej o tym, co buduje Ritual.

4,73K

Najlepsze

Ranking

Ulubione