Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier is de Ritual Research Digest van deze week, een nieuwsbrief die het laatste nieuws in de wereld van LLM's en de kruising van Crypto x AI behandelt.

Met honderden gepubliceerde artikelen per week is het onmogelijk om op de hoogte te blijven van het laatste nieuws. Wij doen het lezen zodat jij dat niet hoeft te doen.

Multi-Module GRPO: Samenstellen van Beleidsgradiënten en Promptoptimalisatie voor Taalmodelprogramma's

Dit artikel onderzoekt of post-training kan worden toegepast op promptoptimalisatiekaders.

Dit is de eerste implementatie van GRPO in complexe LLM-pijplijnen. De methode MM-GRPO verbetert de prestaties met gemiddeld 7% ten opzichte van vanilla CoT. Hoewel het niet altijd beter is dan promptoptimalisatie, is het altijd een effectieve aanvulling.

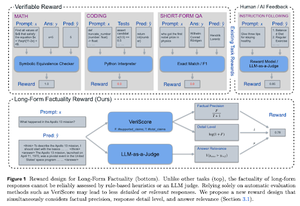

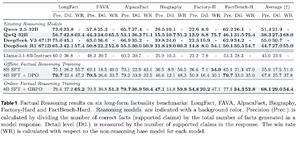

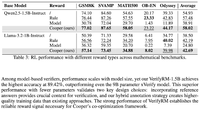

Redeneren voor Feitelijkheid Leren

Dit paper ontwikkelt een beloningsfunctie voor het trainen van lange CoT (Chain of Thought) voor feitelijkheid. Hun ontwerp voorkomt beloningshack door precisie, detail en kwaliteit tegelijkertijd te bevoordelen.

Ze ontdekken dat hun beloningsfunctie in RL beter presteert dan het basismodel (Llama-3.1-8B-Instruct) op alle metrics over verschillende datasets. Bestaande redeneermodellen (QwQ, R1) lijden onder een afname van de feitelijkheid in vergelijking met hun basismodel (Qwen 2.5 32B, DS v3).

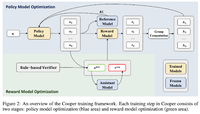

Cooper: Co-Optimaliseren van Beleid en Beloningsmodellen in Versterkend Leren voor Grote Taalmodellen

In dit artikel stellen ze een RL-methode voor, Cooper, die het beleidsmodel en het beloningsmodel gelijktijdig traint.

Ze publiceren een dataset voor beloningsmodellering, die is gelabeld met een strategie die regelgebaseerde en LLM-als-rechter verificatie combineert. Ze ontdekken dat het dynamisch aanpassen van het beloningsmodel tijdens RL effectief kan helpen om beloningshack te verminderen.

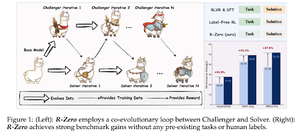

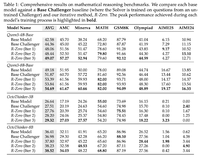

R-Zero: Zelf-evoluerende redeneermodule (LLM) van nul data

In dit artikel stellen ze R-Zero voor voor het trainen van redeneermodellen (LLM's) die zich zelf kunnen ontwikkelen vanuit 0 externe data. Hetzelfde model wordt geïnitieerd met twee rollen (Uitdager/Oplosser) die co-evolueren in RL.

De Challenger wordt beloond voor het genereren van taken die moeilijk zijn voor de huidige vaardigheden van de Solver, terwijl de Solver wordt beloond voor het oplossen van deze steeds moeilijker wordende taken die door de Challenger worden gepresenteerd. R-Zero is een model-agnostisch framework, en ze tonen verbeteringen op het Qwen3-4b model.

Ze presenteren ook CompassVerifier, een familie van robuuste verificatiemodellen. Getraind met gegevens van de originele bank, formule-verbeterde gegevens en hallucinatiegegevens. Hun model presteert beter dan andere modellen zoals de Qwen2.5- en 3-serie en is ook nuttig als beloningsmodel.

Volg ons @ritualdigest voor meer over alles wat met Crypto x AI-onderzoek te maken heeft, en @ritualnet om meer te leren over wat Ritual aan het bouwen is.

4,78K

Boven

Positie

Favorieten