Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aqui está o Ritual Research Digest desta semana, um boletim informativo que cobre as últimas novidades no mundo dos LLMs e a interseção de Crypto x AI.

Com centenas de artigos publicados semanalmente, é impossível manter-se atualizado com as últimas novidades. Faremos a leitura para que você não precise.

GRPO de vários módulos: compondo gradientes de política e otimização de prompt para programas de modelo de linguagem

Este artigo explora se o pós-treinamento pode ser aplicado a estruturas de otimização imediata.

Esta é a primeira implementação do GRPO para pipelines LLM complexos. O método MM-GRPO melhora o desempenho em 7% em média contra o CoT de baunilha. Embora nem sempre supere a otimização imediata, é sempre um elogio eficaz.

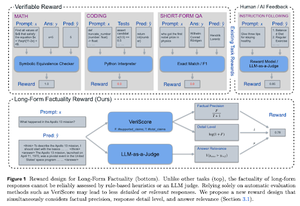

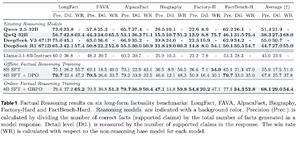

Aprendendo a raciocinar pela factualidade

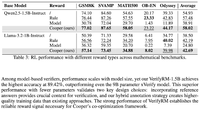

Este artigo desenvolve uma função de recompensa para treinar CoT (Cadeia de Pensamento) longa para factualidade. Seu design impede o hacking de recompensas, favorecendo precisão, detalhes e qualidade ao mesmo tempo.

Eles descobriram que sua função de recompensa em RL supera o modelo base (Llama-3.1-8B-Instruct) em todas as métricas em vários conjuntos de dados. Os LLMs de raciocínio existentes (QwQ, R1) sofrem diminuição de factualidade em comparação com seu modelo base (Qwen 2.5 32B, DS v3).

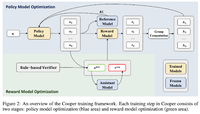

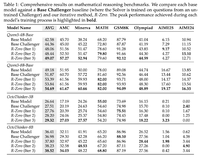

Cooper: Co-otimizando Modelos de Política e Recompensa no Aprendizado por Reforço para Grandes Modelos de Linguagem

Neste artigo, eles propõem um método RL, Cooper, que treina o modelo de política e o modelo de recompensa simultaneamente.

Eles lançam um conjunto de dados de modelagem de recompensa, que é rotulado usando uma estratégia que combina verificação baseada em regras e LLM como juiz. Eles descobriram que ajustar dinamicamente o modelo de recompensa durante o RL pode efetivamente mitigar o hacking de recompensa.

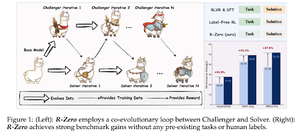

R-Zero: LLM de raciocínio autoevolutivo a partir de zero dados

Neste artigo, eles propõem R-Zero para treinar LLMs de raciocínio que podem evoluir a partir de 0 dados externos. O mesmo modelo é inicializado com duas funções (Challenger/Solver) que co-evoluem em RL.

O Desafiante é recompensado por gerar tarefas que são difíceis para as habilidades atuais do Solver, enquanto o Solver é recompensado por resolver essas tarefas cada vez mais difíceis colocadas pelo Challenger. R-Zero é uma estrutura independente de modelo e mostra ganhos no modelo Qwen3-4b.

Eles também apresentam o CompassVerifier, uma família de modelos de verificação robustos. Treinado com dados do banco original, dados aprimorados por fórmula e dados de alucinação. Seu modelo tem um desempenho melhor do que outros modelos como Qwen2.5 & 3 series & é útil como um modelo de recompensa também.

Siga-nos @ritualdigest para saber mais sobre todas as pesquisas sobre Crypto x AI e @ritualnet para saber mais sobre o que a Ritual está construindo.

6,14K

Melhores

Classificação

Favoritos