Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier ist der Ritual Research Digest dieser Woche, ein Newsletter, der die neuesten Entwicklungen in der Welt der LLMs und der Schnittstelle von Crypto x AI abdeckt.

Bei Hunderten von wöchentlich veröffentlichten Arbeiten ist es unmöglich, mit den neuesten Entwicklungen Schritt zu halten. Wir werden die Lektüre übernehmen, damit Sie es nicht müssen.

Multi-Module GRPO: Zusammensetzung von Policy-Gradienten und Prompt-Optimierung für Sprachmodellprogramme

Dieses Papier untersucht, ob Post-Training auf Frameworks zur Prompt-Optimierung angewendet werden kann.

Dies ist die erste Implementierung von GRPO in komplexe LLM-Pipelines. Die Methode MM-GRPO verbessert die Leistung im Durchschnitt um 7 % im Vergleich zu Vanilla CoT. Obwohl sie nicht immer die Prompt-Optimierung übertrifft, ist sie immer ein effektives Komplement.

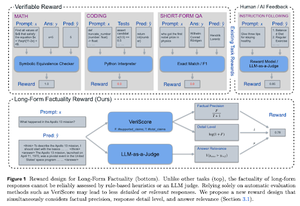

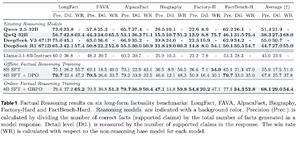

Lernen, um für Faktizität zu argumentieren

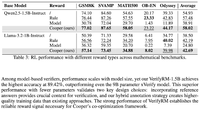

Dieses Papier entwickelt eine Belohnungsfunktion zum Training von langem CoT (Chain of Thought) für Faktizität. Ihr Design verhindert Belohnungshacking, indem es Präzision, Detailgenauigkeit und Qualität gleichzeitig begünstigt.

Sie stellen fest, dass ihre Belohnungsfunktion im RL in allen Metriken über dem Basismodell (Llama-3.1-8B-Instruct) in mehreren Datensätzen abschneidet. Bestehende reasoning LLMs (QwQ, R1) leiden im Vergleich zu ihrem Basismodell (Qwen 2.5 32B, DS v3) unter einem Rückgang der Faktizität.

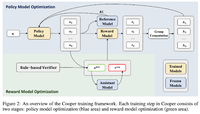

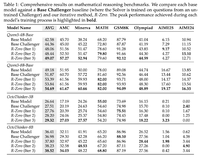

Cooper: Co-Optimierung von Politik- und Belohnungsmodellen im Reinforcement Learning für große Sprachmodelle

In diesem Papier schlagen sie eine RL-Methode vor, Cooper, die das Politikmodell und das Belohnungsmodell gleichzeitig trainiert.

Sie veröffentlichen einen Datensatz zur Belohnungsmodellierung, der mit einer Strategie gekennzeichnet ist, die regelbasierte und LLM-als-Richter-Verifizierung kombiniert. Sie stellen fest, dass die dynamische Anpassung des Belohnungsmodells während des RL effektiv Belohnungshacking mindern kann.

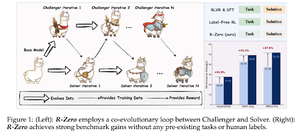

R-Zero: Selbst-evolvierendes Reasoning LLM aus Null Daten

In diesem Papier schlagen sie R-Zero vor, um Reasoning LLMs zu trainieren, die sich aus 0 externen Daten selbst weiterentwickeln können. Dasselbe Modell wird mit zwei Rollen (Herausforderer/Löser) initialisiert, die sich im RL gemeinsam weiterentwickeln.

Der Herausforderer wird dafür belohnt, Aufgaben zu generieren, die für die aktuellen Fähigkeiten des Lösers schwierig sind, während der Löser dafür belohnt wird, diese zunehmend schwierigen Aufgaben zu lösen, die vom Herausforderer gestellt werden. R-Zero ist ein modellunabhängiges Framework, und sie zeigen Fortschritte mit dem Qwen3-4b-Modell.

Sie präsentieren auch CompassVerifier, eine Familie robuster Verifizierungsmodelle. Trainiert mit Daten aus dem ursprünglichen Benchmark, formelverbesserten Daten und Halluzinationsdaten. Ihr Modell schneidet besser ab als andere Modelle wie Qwen2.5 und die 3er-Serie und ist auch als Belohnungsmodell hilfreich.

Folge uns @ritualdigest für mehr über alles, was mit Crypto x AI-Forschung zu tun hat, und @ritualnet, um mehr darüber zu erfahren, was Ritual aufbaut.

4,73K

Top

Ranking

Favoriten