Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ecco il Digest di Ricerca Rituale di questa settimana, una newsletter che copre le ultime novità nel mondo degli LLM e l'intersezione tra Crypto e AI.

Con centinaia di articoli pubblicati settimanalmente, rimanere aggiornati con le ultime novità è impossibile. Noi faremo la lettura così non dovrai farlo tu.

Multi-Module GRPO: Composizione di Gradienti di Politica e Ottimizzazione dei Prompt per Programmi di Modelli Linguistici

Questo articolo esplora se il post-training può essere applicato ai framework di ottimizzazione dei prompt.

Questa è la prima implementazione di GRPO in pipeline LLM complesse. Il metodo MM-GRPO migliora le prestazioni del 7% in media rispetto al CoT standard. Anche se non supera sempre l'ottimizzazione del prompt, è sempre un complemento efficace.

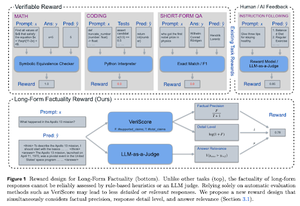

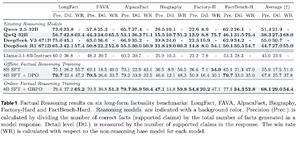

Imparare a Ragionare per la Fattualità

Questo documento sviluppa una funzione di ricompensa per l'addestramento di lunghi CoT (Catene di Pensiero) per la fattualità. Il loro design impedisce il reward hacking favorendo precisione, dettaglio e qualità allo stesso tempo.

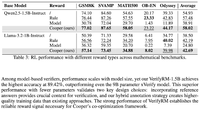

Scoprono che la loro funzione di ricompensa in RL supera il modello di base (Llama-3.1-8B-Instruct) in tutte le metriche su diversi dataset. Gli LLM di ragionamento esistenti (QwQ, R1) soffrono di una diminuzione della factualità rispetto al loro modello di base (Qwen 2.5 32B, DS v3).

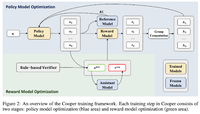

Cooper: Co-ottimizzazione dei modelli di politica e di ricompensa nell'apprendimento per rinforzo per modelli di linguaggio di grandi dimensioni

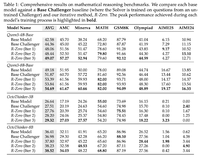

In questo articolo, propongono un metodo di RL, Cooper, che allena simultaneamente il modello di politica e il modello di ricompensa.

Rilasciano un dataset di modellazione delle ricompense, etichettato utilizzando una strategia che combina la verifica basata su regole e LLM come giudice. Scoprono che regolare dinamicamente il modello di ricompensa durante l'RL può mitigare efficacemente il hacking delle ricompense.

R-Zero: LLM di ragionamento auto-evolutivo da zero dati

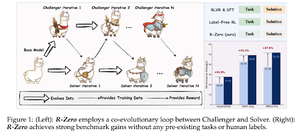

In questo articolo, propongono R-Zero per l'addestramento di LLM di ragionamento che possono auto-evolversi da 0 dati esterni. Lo stesso modello è inizializzato con due ruoli (Sfida/Risolutore) che co-evolvono in RL.

Il Challenger viene premiato per generare compiti che sono difficili per le attuali capacità del Solver, mentre il Solver viene premiato per risolvere questi compiti sempre più difficili posti dal Challenger. R-Zero è un framework indipendente dal modello e mostrano guadagni sul modello Qwen3-4b.

Presentano anche CompassVerifier, una famiglia di modelli di verifica robusti. Addestrati con dati provenienti dal banco originale, dati migliorati da formule e dati di allucinazione. Il loro modello funziona meglio di altri modelli come Qwen2.5 e 3 serie ed è utile anche come modello di ricompensa.

Seguici su @ritualdigest per ulteriori informazioni su tutto ciò che riguarda la ricerca Crypto x AI, e su @ritualnet per saperne di più su cosa sta costruendo Ritual.

4,4K

Principali

Ranking

Preferiti