トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

今週の Ritual Research Digest は、LLM の世界の最新情報と Crypto x AI の交差点をカバーするニュースレターです。

毎週何百もの論文が発行されているため、最新の情報を入手することは不可能です。私たちがリーディングをしますので、その必要はありません。

マルチモジュールGRPO:言語モデルプログラムのためのポリシー勾配とプロンプト最適化の構成

この論文では、ポストトレーニングをプロンプト最適化フレームワークに適用できるかどうかを探ります。

これは、複雑なLLMパイプラインへのGRPOの最初の実装です。MM-GRPO法は、バニラCoTに対して平均7%の性能を向上させます。必ずしも迅速な最適化を上回るわけではありませんが、常に効果的な褒め言葉です。

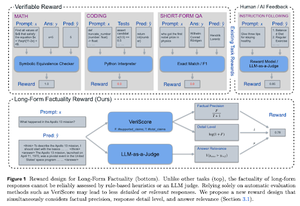

事実性を推論することを学ぶ

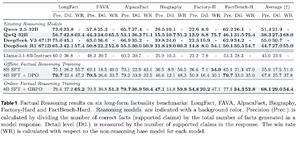

この論文では、事実性のために長いCoT(Chain of Thought)をトレーニングするための報酬関数を開発します。彼らのデザインは、精度、詳細、品質を同時に優先することで、報酬ハッキングを阻止します。

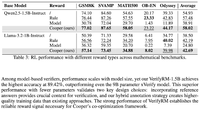

彼らは、RL の報酬関数が、複数のデータセットにわたるすべての指標で基本モデル (Llama-3.1-8B-Instruct) よりも優れていることを発見しました。既存の推論 LLM (QwQ、R1) は、基本モデル (Qwen 2.5 32B、DS v3) と比較して事実性の低下に悩まされています。

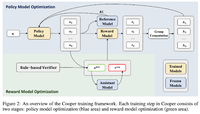

Cooper: 大規模言語モデルの強化学習におけるポリシーと報酬モデルの共同最適化

本論文では、政策モデルと報酬モデルを同時に学習させるRL手法Cooperを提案しています。

彼らは、ルールベースの検証と裁判官としてのLLMの検証を組み合わせた戦略を使用してラベル付けされた報酬モデリングデータセットをリリースします。彼らは、RL 中に報酬モデルを動的に調整することで、報酬ハッキングを効果的に軽減できることを発見しました。

R-Zero: ゼロデータからの自己進化推論 LLM

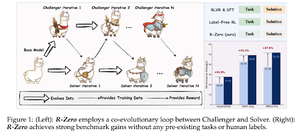

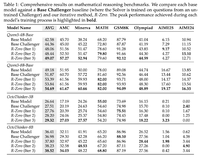

本論文では、外部データ0個から自己進化できる推論LLMを学習させるためのR-Zeroを提案しています。同じモデルが、RLで共進化する2つの役割(チャレンジャー/ソルバー)で初期化されます。

チャレンジャーは、ソルバーの現在の能力では難しいタスクを生成すると報酬を受け取り、ソルバーはチャレンジャーによって提起されるますます困難になるタスクを解決すると報酬が与えられます。R-Zero はモデルに依存しないフレームワークであり、Qwen3-4b モデルで利点を示しています。

また、堅牢な検証モデルのファミリーである CompassVerifier も紹介します。元のベンチのデータ、数式で強化されたデータ、幻覚データでトレーニングされています。彼らのモデルは、Qwen2.5 や 3 シリーズなどの他のモデルよりも優れたパフォーマンスを発揮し、報酬モデルとしても役立ちます。

Crypto x AI の研究に関するすべての詳細@ritualdigest、そして Ritual が構築しているものについて詳しく知るために@ritualnetフォローしてください。

4.4K

トップ

ランキング

お気に入り