Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Đây là bản Tóm tắt Nghiên cứu Ritual của tuần này, một bản tin bao quát những điều mới nhất trong thế giới LLM và giao thoa giữa Crypto x AI.

Với hàng trăm tài liệu được công bố hàng tuần, việc cập nhật những điều mới nhất là điều không thể. Chúng tôi sẽ làm việc đọc để bạn không phải.

Multi-Module GRPO: Kết hợp Gradient Chính sách và Tối ưu hóa Prompt cho các Chương trình Mô hình Ngôn ngữ

Bài báo này khám phá xem việc huấn luyện sau có thể được áp dụng cho các khung tối ưu hóa prompt hay không.

Đây là lần triển khai đầu tiên của GRPO vào các quy trình LLM phức tạp. Phương pháp MM-GRPO cải thiện hiệu suất trung bình 7% so với CoT nguyên bản. Mặc dù nó không phải lúc nào cũng vượt qua tối ưu hóa prompt, nhưng nó luôn là một sự bổ sung hiệu quả.

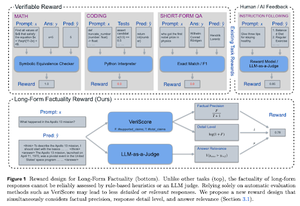

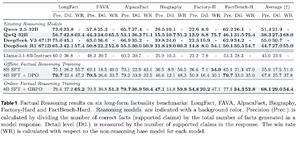

Học cách Lập luận để Đảm bảo Tính chính xác

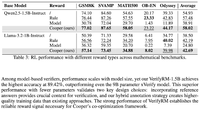

Bài báo này phát triển một hàm thưởng để đào tạo CoT dài (Chuỗi Tư duy) cho tính chính xác. Thiết kế của họ ngăn chặn việc khai thác phần thưởng bằng cách ưu tiên độ chính xác, chi tiết và chất lượng cùng một lúc.

Họ nhận thấy rằng hàm thưởng của họ trong RL vượt trội hơn mô hình cơ sở (Llama-3.1-8B-Instruct) ở tất cả các chỉ số trên nhiều tập dữ liệu. Các LLM lý luận hiện có (QwQ, R1) gặp phải sự giảm sút về tính chính xác so với mô hình cơ sở của chúng (Qwen 2.5 32B, DS v3).

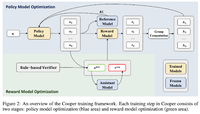

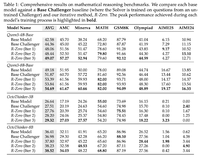

Cooper: Tối ưu hóa đồng thời mô hình chính sách và mô hình phần thưởng trong học tăng cường cho các mô hình ngôn ngữ lớn

Trong bài báo này, họ đề xuất một phương pháp RL, Cooper, mà đào tạo mô hình chính sách và mô hình phần thưởng đồng thời.

Họ phát hành một tập dữ liệu mô hình thưởng, được gán nhãn bằng một chiến lược kết hợp giữa xác minh dựa trên quy tắc và LLM như một thẩm phán. Họ nhận thấy rằng việc điều chỉnh động mô hình thưởng trong quá trình RL có thể giảm thiểu hiệu quả việc hack thưởng.

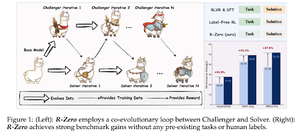

R-Zero: Mô hình LLM Tư duy Tự phát triển từ Dữ liệu Không

Trong bài báo này, họ đề xuất R-Zero để đào tạo các mô hình LLM tư duy có khả năng tự phát triển từ 0 dữ liệu bên ngoài. Mô hình giống nhau được khởi tạo với hai vai trò (Thách thức/Giải quyết) cùng phát triển trong RL.

Người Thách thức được thưởng cho việc tạo ra các nhiệm vụ khó khăn đối với khả năng hiện tại của Người Giải quyết, trong khi Người Giải quyết được thưởng cho việc giải quyết những nhiệm vụ ngày càng khó khăn do Người Thách thức đặt ra. R-Zero là một khung mô hình không phụ thuộc, và họ cho thấy những cải tiến trên mô hình Qwen3-4b.

Họ cũng giới thiệu CompassVerifier, một gia đình các mô hình xác minh mạnh mẽ. Được đào tạo với dữ liệu từ băng gốc, dữ liệu được cải tiến bằng công thức & dữ liệu ảo giác. Mô hình của họ hoạt động tốt hơn các mô hình khác như Qwen2.5 & 3 series & cũng hữu ích như một mô hình thưởng.

Theo dõi chúng tôi @ritualdigest để biết thêm về tất cả các nghiên cứu liên quan đến Crypto x AI, và @ritualnet để tìm hiểu thêm về những gì Ritual đang xây dựng.

4,73K

Hàng đầu

Thứ hạng

Yêu thích