熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

這是本週的 Ritual Research Digest,這是一份涵蓋 LLM 世界及 Crypto x AI 交集的新聞通訊。

每週有數百篇論文發表,跟上最新動態幾乎是不可能的。我們會幫你閱讀,讓你無需費心。

多模組 GRPO:為語言模型程序組合政策梯度和提示優化

本文探討後訓練是否可以應用於提示優化框架。

這是將 GRPO 首次應用於複雜的 LLM 流程。方法 MM-GRPO 在平均上比原始的 CoT 提高了 7% 的性能。雖然它並不總是超越提示優化,但它始終是一個有效的補充。

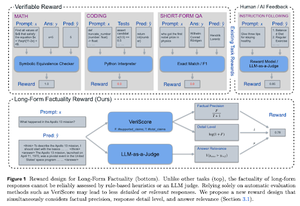

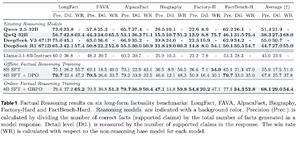

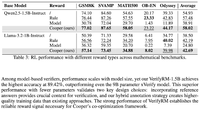

學習推理以確保事實性

本文開發了一個獎勵函數,用於訓練長鏈思維(CoT)以確保事實性。他們的設計通過同時重視精確性、細節和質量來防止獎勵黑客行為。

他們發現,在多個數據集上,他們在強化學習中的獎勵函數在所有指標上都超越了基礎模型(Llama-3.1-8B-Instruct)。現有的推理大型語言模型(QwQ, R1)與其基礎模型(Qwen 2.5 32B, DS v3)相比,事實性有所下降。

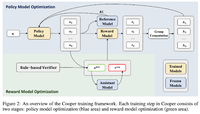

Cooper:在大型語言模型中共同優化強化學習的政策和獎勵模型

在這篇論文中,他們提出了一種強化學習方法,Cooper,該方法同時訓練政策模型和獎勵模型。

他們發布了一個獎勵建模數據集,該數據集使用結合基於規則和 LLM 作為評判的驗證策略進行標記。他們發現,在強化學習過程中動態調整獎勵模型可以有效減輕獎勵黑客行為。

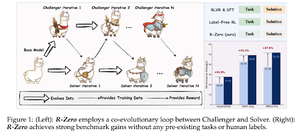

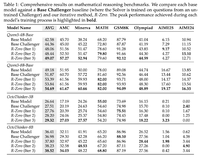

R-Zero:從零數據自我演化的推理 LLM

在這篇論文中,他們提出了 R-Zero,用於訓練可以從零外部數據自我演化的推理 LLM。相同的模型以兩個角色(挑戰者/解決者)初始化,並在強化學習中共同演化。

挑戰者因為生成對解決者當前能力來說困難的任務而獲得獎勵,而解決者則因為解決這些挑戰者提出的日益困難的任務而獲得獎勵。R-Zero是一個模型無關的框架,他們在Qwen3-4b模型上顯示出增益。

他們還推出了CompassVerifier,一系列強大的驗證模型。這些模型是使用來自原始基準、公式增強數據和幻覺數據的數據進行訓練的。他們的模型表現優於其他模型,如Qwen2.5和3系列,並且作為獎勵模型也很有幫助。

關注我們 @ritualdigest 獲取更多有關加密貨幣與人工智慧研究的資訊,並關注 @ritualnet 了解 Ritual 正在構建的內容。

4.19K

熱門

排行

收藏