热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

这是本周的仪式研究摘要,一份涵盖LLM世界和加密货币与人工智能交集的最新动态的通讯。

每周有数百篇论文发表,跟上最新动态几乎是不可能的。我们会为您阅读,以便您无需亲自去看。

多模块 GRPO:为语言模型程序组合策略梯度和提示优化

本文探讨了后训练是否可以应用于提示优化框架。

这是GRPO在复杂LLM管道中的首次实现。方法MM-GRPO在平均上比普通的CoT提高了7%的性能。虽然它并不总是超过提示优化,但它始终是一个有效的补充。

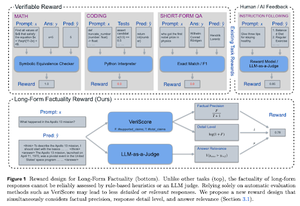

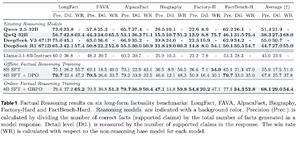

学习推理以确保事实准确性

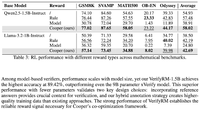

本文开发了一种奖励函数,用于训练长链思维(CoT)以确保事实准确性。他们的设计通过同时重视精确性、细节和质量来防止奖励黑客行为。

他们发现,在多个数据集上,他们的强化学习奖励函数在所有指标上都优于基础模型(Llama-3.1-8B-Instruct)。现有的推理大型语言模型(QwQ,R1)与其基础模型(Qwen 2.5 32B,DS v3)相比,事实性下降。

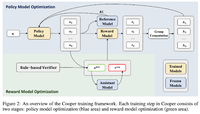

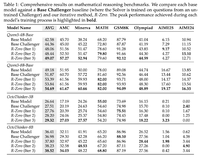

Cooper:在大型语言模型中共同优化强化学习的策略和奖励模型

在本文中,他们提出了一种RL方法Cooper,同时训练策略模型和奖励模型。

他们发布了一个奖励建模数据集,该数据集使用结合基于规则和LLM作为评判者验证的策略进行标记。他们发现,在强化学习过程中动态调整奖励模型可以有效缓解奖励黑客行为。

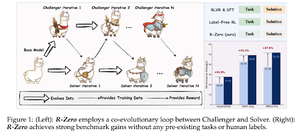

R-Zero:从零数据自我进化的推理LLM

在本文中,他们提出了R-Zero,用于训练能够从零外部数据自我进化的推理LLM。相同的模型初始化为两个角色(挑战者/解决者),在强化学习中共同进化。

挑战者因生成对解决者当前能力而言困难的任务而获得奖励,而解决者则因解决这些挑战者提出的日益困难的任务而获得奖励。R-Zero是一个与模型无关的框架,他们在Qwen3-4b模型上显示出收益。

他们还推出了CompassVerifier,一个强大的验证模型系列。使用来自原始基准、公式增强数据和幻觉数据的数据进行训练。他们的模型表现优于其他模型,如Qwen2.5和3系列,并且作为奖励模型也很有帮助。

关注我们 @ritualdigest,获取更多关于加密货币与人工智能研究的内容,关注 @ritualnet 了解 Ritual 正在构建的内容。

4.19K

热门

排行

收藏