Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Voici le Digest de Recherche Rituel de cette semaine, une newsletter couvrant les dernières nouvelles dans le monde des LLM et l'intersection entre Crypto et IA.

Avec des centaines d'articles publiés chaque semaine, il est impossible de rester à jour avec les dernières informations. Nous ferons la lecture pour que vous n'ayez pas à le faire.

Multi-Module GRPO : Composition des gradients de politique et optimisation des invites pour les programmes de modèles de langage

Cet article explore si l'entraînement postérieur peut être appliqué aux cadres d'optimisation des invites.

Ceci est la première mise en œuvre de GRPO dans des pipelines LLM complexes. La méthode MM-GRPO améliore les performances de 7 % en moyenne par rapport à CoT classique. Bien qu'elle ne dépasse pas toujours l'optimisation des invites, elle constitue toujours un complément efficace.

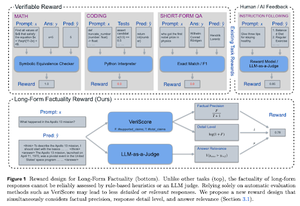

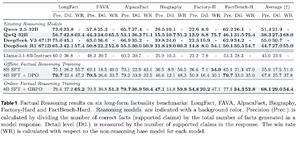

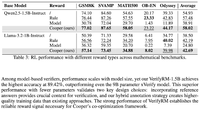

Apprendre à raisonner pour la factualité

Cet article développe une fonction de récompense pour entraîner le long CoT (Chaîne de Pensée) pour la factualité. Leur conception empêche le hacking de récompense en favorisant la précision, le détail et la qualité en même temps.

Ils constatent que leur fonction de récompense en RL surpasse le modèle de base (Llama-3.1-8B-Instruct) dans toutes les métriques à travers plusieurs ensembles de données. Les LLMs de raisonnement existants (QwQ, R1) souffrent d'une diminution de la factualité par rapport à leur modèle de base (Qwen 2.5 32B, DS v3).

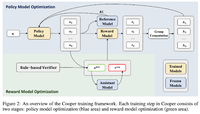

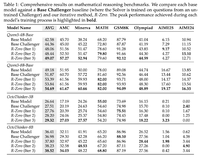

Cooper : Co-optimisation des modèles de politique et de récompense dans l'apprentissage par renforcement pour les grands modèles de langage

Dans cet article, ils proposent une méthode d'apprentissage par renforcement, Cooper, qui entraîne simultanément le modèle de politique et le modèle de récompense.

Ils publient un ensemble de données de modélisation des récompenses, qui est étiqueté en utilisant une stratégie qui combine la vérification basée sur des règles et LLM en tant que juge. Ils constatent que l'ajustement dynamique du modèle de récompense pendant le RL peut efficacement atténuer le hacking des récompenses.

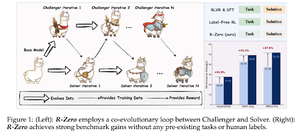

R-Zero : LLM de raisonnement auto-évolutif à partir de zéro données

Dans cet article, ils proposent R-Zero pour former des LLM de raisonnement qui peuvent s'auto-évoluer à partir de 0 données externes. Le même modèle est initialisé avec deux rôles (Challenger/Solver) qui co-évoluent en RL.

Le Challenger est récompensé pour la génération de tâches qui sont difficiles pour les capacités actuelles du Solver, tandis que le Solver est récompensé pour la résolution de ces tâches de plus en plus difficiles posées par le Challenger. R-Zero est un cadre indépendant du modèle, et ils montrent des gains sur le modèle Qwen3-4b.

Ils présentent également CompassVerifier, une famille de modèles de vérification robustes. Entraînés avec des données du banc d'origine, des données améliorées par des formules et des données d'hallucination. Leur modèle fonctionne mieux que d'autres modèles comme Qwen2.5 et la série 3 et est utile en tant que modèle de récompense.

Suivez-nous @ritualdigest pour en savoir plus sur tout ce qui concerne la recherche Crypto x IA, et @ritualnet pour en apprendre davantage sur ce que Ritual est en train de construire.

4,19K

Meilleurs

Classement

Favoris