热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

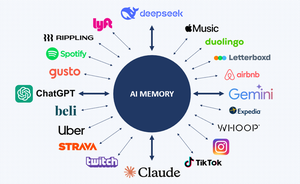

在 @finalitycap,我们认为“AI内存的Plaid”是一个巨大的机会。想象一下,每个应用程序或AI模型都能立即了解你的背景、偏好、兴趣和历史。

这对用户体验和成本来说都是巨大的影响 🧵👇

感谢 @binji_x @nikunj @ashleymayer @levie 激发了伟大的想法:

2/

今天,每个AI模型都将你的聊天内容隔离。ChatGPT不知道你的Claude或Gemini历史,甚至不知道你的身份🪪

用户浪费时间和金钱重新解释自己。这不仅令人沮丧,而且也很昂贵💸

3/

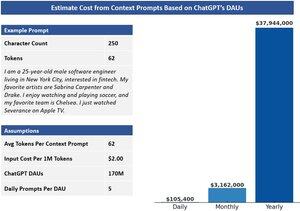

用户在每个会话中重新输入个人信息、偏好等上下文,浪费了代币和金钱。

由于LLM按代币收费,这种低效会累积。

在ChatGPT的规模下,重复的上下文每年可能仅在计算上就花费近4000万美元……这是计算方式。

4/

人工智能公司正在遵循经典的大型科技公司策略:将用户数据锁定在封闭的花园中以最大化利润

更多用户数据 = 更多收入 🤑

这就是为什么科技巨头们基于用户信息建立了广告帝国。是时候将控制权交还给用户了。

5/

记忆将成为人工智能公司用来锁定用户并提高转换成本的新护城河🌊

我们已经看到这一点在OpenAI的新记忆功能中展开

也许有一天我们会通过“使用OpenAI登录”进行OAuth 🔑,但真正的灵活性仍然缺失

锁定将变得更加重要,因为不同的人工智能模型在通用、搜索、编码、治疗等领域表现出色。

像 @layerlens_ai 这样的项目,正在 @eigenlayer 上构建人工智能评估基准,将使这些差异变得清晰,并突出模型间可移植性的真正价值 🔄

7/

使用 MCP 的团队可以让 AI 模型安全地访问和更新来自多个来源的用户上下文,但这仍然需要访问 API

通过 @OpacityNetwork 的 zkTLS 可以统一来自 web2 应用程序的数据,包括那些无法通过公共 API 访问的数据,同时保持底层数据的私密性

8/

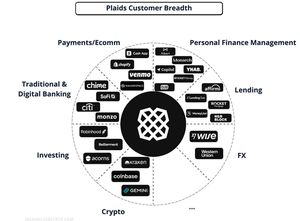

@Plaid 通过解锁金融数据访问和新应用程序,改变了 web2 金融科技。

Plaid for AI Memory 也可以做到这一点,为新一波 AI 驱动的体验和应用程序提供动力。

12.77K

热门

排行

收藏