Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ZÍVNOUT 🥱

Dokonce i Meituan (společnost zabývající se doručovacími aplikacemi ~ DoorDash) dodává hraniční LLM >> Meta. Níže uvedená citace příspěvku popisuje mnoho technických triků SOTA použitých v modelu 560B MoE.

Před lety jsem se setkal s trenérem týmu IMO ČLR v Pekingu. Řekl mi, že pokud chtějí, mohou každý rok postavit několik týmů zlatých medailistů. Výkon týmů genAI v Číně to podporuje - ztratil jsem přehled o počtu vyrobených modelů, které jsou >> Meta a SOTA.

~ Polovina talentů v oblasti umělé inteligence na světě je v Číně a polovina amerických talentů v oblasti umělé inteligence je z Číny.

Pro bezradné Američany, kteří se neobtěžují sledovat největší a (pravděpodobně) nejinovativnější ekonomiku na světě:

Meituan (čínsky: 美團; pinyin: Měituán, doslova "krásná skupina"; dříve Meituan–Dianping, doslova "krásná skupina – recenze") je čínská technologická společnost, která nabízí platformu pro širokou škálu místních spotřebitelů, včetně rozvozu jídla, restaurací recenze, cestovní rezervace a maloobchodní služby. Společnost má sídlo v Pekingu a byla založena v roce 2010 Wang Xingem.

31. 8. 2025

Technická zpráva @Meituan_LongCat LongCat-Flash je šíleně dobrá a plná novinek.

Model je 560B pasivní ~27B aktivní MoE s adaptivním počtem aktivních parametrů v závislosti na kontextu díky Zero-Computational expertovi.

1) Nová architektura

> vrstvy mají 2 bloky pozornosti a FFN i MoE, takže se můžete překrývat se 2 all-to-all comy. (také je to jen 28 vrstev, ale musíte vzít v úvahu 2 bloky pozornosti).

> Přidávají odborníka na nulový výpočet, že tokeny si mohou vybrat a nedělat nic, něco jako "jímka" pro snadné tokeny.

> Pro vyvažování zátěže mají aux loss podobný dsv3 zdarma pro nastavení průměrného skutečného/falešného experta na token. Na tuto aktualizaci zkreslení aplikují plán rozpadu. Provádějí také kontrolu zůstatku ztrát.

2) Změna měřítka

> Provedli změny v MLA/MoE, aby měli zarovnání rozptylu v inicializaci. Zisky jsou na obrázku 5 docela působivé, ale nevím, do jaké míry to bude mít dopad později.

> Model growth init je docela cool, nejprve natrénují 2x menší model a pak "když je to dostatečně natrénované" (tady trochu není jasné, kolik B tokenů) inicializují finální model tím, že prostě naskládají vrstvy menšího modelu.

> Použili @_katieeverett @Locchiu a al. papír pro přenos hyperparametrů s SP místo muP pro 2x menší model ig.

3) Stabilita

> Sledují poměr Gradient Norm Ratio a kosinus podobnosti mezi odborníky, aby upravili váhu ztráty vyvažování zátěže (doporučují Gradient Norm Ratio <0,1). > Aby se vyhnuli velkým aktivacím, aplikují z-loss na skrytý stav s docela malým coefem (další alternativa k qk-clip/norm).

> Nastaví Adam epsilon na 1e-16 a ukážou, že chcete, aby byl nižší než rozsah RMS gradientu.

4) Ostatní

> Trénují na 20T tokenech pro fázi 1, "více T tokenů" pro střední trénování na datech STEM/kódu (70 % mixu), 100B pro rozšíření dlouhého kontextu bez příze (80B pro 32k, 20B pro 128k). Dokumenty s dlouhým kontextem představují 25 % mixu (nejsem si jistý, jestli je to % dokumentů nebo tokenů, což se zde hodně mění).

> Pre-trénovacím datovým kanálem je extrakce kontextu, filtrování kvality, deduplikace.

> Pěkný dodatek, kde ukazují, že porovnávají top_k potřebné pro různé benchmarky (vyšší MMLU s 8,32, nižší GSM8K s 7,46). Porovnávají také alokaci tokenů v hlubokých/mělkých vrstvách.

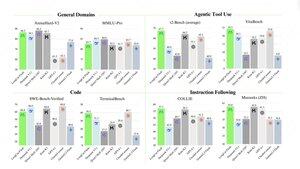

> Vydávají dva nové benchmarky Meeseeks (víceotáčkové IF) a VitaBench (reálný obchodní scénář).

> Spousta detailů v infra/inferenci s informacemi o spekulativním dekódování, přijetí, kvantizaci, nasazení, optimalizaci jádra, překrývání coms atd.

> Seznam různých relevantních článků ve vlákně 🧵

11,94K

Top

Hodnocení

Oblíbené