Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

MENGUAP 🥱

Bahkan Meituan (perusahaan aplikasi pengiriman ~ DoorDash) mengirimkan LLM perbatasan >> Meta. Posting saya kutip di bawah ini menjelaskan banyak trik teknis SOTA yang digunakan dalam model 560B MoE.

Bertahun-tahun yang lalu saya bertemu dengan pelatih tim IMO RRT di Beijing. Dia mengatakan kepada saya bahwa mereka dapat menurunkan beberapa tim peraih medali emas setiap tahun jika mereka mau. Kinerja tim genAI di China mendukung hal ini - saya kehilangan hitungan jumlah model yang diproduksi di sana yang >> Meta dan SOTA.

~ Setengah dari bakat AI di dunia adalah DI China dan setengah dari bakat AI AS adalah DARI China.

Untuk orang Amerika yang tidak tahu apa-apa yang tidak repot-repot mengikuti ekonomi terbesar dan (bisa dibilang) paling inovatif di dunia:

Meituan (Hanzi: 美團; pinyin: Měituán, secara harfiah "kelompok yang indah"; sebelumnya Meituan-Dianping, secara harfiah "ulasan grup yang indah") adalah perusahaan teknologi Tiongkok yang menawarkan platform untuk berbagai konsumen lokal, termasuk pengiriman makanan, restoran. ulasan, pemesanan perjalanan, dan layanan ritel. Perusahaan ini berkantor pusat di Beijing dan didirikan pada tahun 2010 oleh Wang Xing.

22 jam lalu

Laporan teknis @Meituan_LongCat LongCat-Flash sangat bagus dan penuh dengan hal baru.

Model ini adalah MoE aktif pasif ~27B 560B dengan jumlah parameter aktif adaptif tergantung pada konteks berkat pakar Komputasi Nol.

1) Arsitektur baru

> Layer memiliki 2 blok Perhatian dan FFN dan MoE, dengan begitu Anda dapat tumpang tindih dengan 2 coms all-to-all. (juga hanya 28 lapisan tetapi Anda harus memperhitungkan 2 blok perhatian).

> Mereka menambahkan ahli komputasi nol bahwa token dapat memilih dan tidak melakukan apa-apa, seperti "wastafel" untuk token yang mudah.

> Untuk penyeimbangan beban, mereka memiliki aux loss seperti dsv3 gratis untuk mengatur rata-rata ahli nyata/palsu per token. Mereka menerapkan jadwal peluruhan untuk pembaruan bias ini. Mereka juga melakukan kontrol keseimbangan kerugian.

2) Penskalaan

> Mereka membuat perubahan pada MLA/MoE untuk memiliki penyelarasan varians di init. Keuntungannya cukup mengesankan pada Gambar 5, tetapi saya tidak tahu sejauh mana dampaknya di kemudian hari.

> Model pertumbuhan init cukup keren, mereka pertama-tama melatih model 2x lebih kecil dan kemudian "ketika sudah cukup terlatih" (agak tidak jelas di sini berapa banyak token B) mereka memulai model akhir hanya dengan menumpuk lapisan model yang lebih kecil.

> Mereka menggunakan kertas @_katieeverett @Locchiu dan al. untuk memiliki transfer hiperparameter dengan SP alih-alih muP untuk model 2x lebih kecil ig.

3) Stabilitas

> Mereka melacak Rasio Norma Gradien dan kesamaan kosinus antara para ahli untuk menyesuaikan bobot kehilangan penyeimbangan beban (mereka merekomendasikan Rasio Norma Gradien <0,1). > Untuk menghindari aktivasi besar, mereka menerapkan z-loss ke keadaan tersembunyi, dengan coef yang cukup kecil (alternatif lain untuk qk-clip/norm).

> Mereka mengatur Adam epsilon ke 1e-16 dan menunjukkan bahwa Anda ingin lebih rendah dari rentang RMS gradien.

4) Lainnya

> Mereka berlatih pada token 20T untuk fase 1, "beberapa T token" untuk pelatihan menengah pada data STEM/kode (70% dari campuran), 100B untuk ekstensi konteks panjang tanpa benang (80B untuk 32k, 20B untuk 128k). Dokumen konteks panjang mewakili 25% dari campuran (tidak yakin apakah itu % dari dokumen atau token, yang banyak berubah di sini).

> Alur data pra-pelatihan adalah ekstraksi konteks, pemfilteran kualitas, dedup.

> lampiran yang bagus di mana mereka menunjukkan bahwa mereka membandingkan top_k yang dibutuhkan untuk tolok ukur yang berbeda (MMLU yang lebih tinggi dengan 8,32, GSM8K yang lebih rendah dengan 7,46). Mereka juga membandingkan alokasi token dalam lapisan dalam/dangkal.

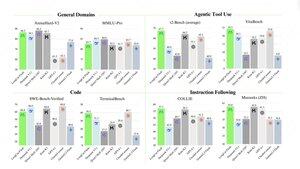

> Mereka merilis dua tolok ukur baru: Meeseeks (multi-turn IF) dan VitaBench (skenario bisnis dunia nyata).

> Banyak detail dalam infra/inferensi dengan info tentang penerimaan decoding spekulatif, kuantisasi, penerapan, pengoptimalan kernel, tumpang tindih com, dll.

> Daftar makalah terkait yang berbeda dalam utas 🧵

11,91K

Teratas

Peringkat

Favorit