Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GJESPE 🥱

Til og med Meituan (leveringsappselskap ~ DoorDash) sender grense LLM >> Meta. Innlegg jeg siterer nedenfor beskriver mange SOTA tekniske triks som brukes i 560B MoE-modellen.

For mange år siden møtte jeg treneren for PRC IMO-laget i Beijing. Han fortalte meg at de kunne stille med flere lag med gullmedaljevinnere hvert år hvis de ville. Ytelsen til genAI-team i Kina støtter dette - jeg har mistet tellingen på antall modeller produsert der som er >> Meta og SOTA.

~Halvparten av AI-talentene i verden er I Kina og halvparten av de amerikanske AI-talentene er FRA Kina.

For uvitende amerikanere som ikke gidder å følge den største og (uten tvil) mest innovative økonomien i verden:

Meituan (kinesisk: 美團; pinyin: Měituán, bokstavelig talt «vakker gruppe»; tidligere Meituan–Dianping, bokstavelig talt «vakre gruppeanmeldelser») er et kinesisk teknologiselskap som tilbyr en plattform for et bredt spekter av lokale forbrukere, inkludert matlevering, restaurant anmeldelser, reisebestillinger og detaljhandelstjenester. Selskapet har hovedkontor i Beijing og ble grunnlagt i 2010 av Wang Xing.

31. aug. 2025

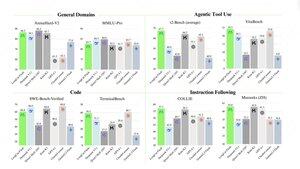

Den tekniske rapporten til @Meituan_LongCat LongCat-Flash er vanvittig god og full av nyheter.

Modellen er en 560B passiv ~27B aktiv MoE med adaptivt antall aktive parametere avhengig av konteksten takket være Zero-Computational-eksperten.

1) Ny arkitektur

> lag har 2 oppmerksomhetsblokker og både FFN og MoE, på den måten kan du overlappe de 2 alt-til-alle-comene. (Dessuten er det bare 28 lag, men du må ta hensyn til de 2 oppmerksomhetsblokkene).

> De legger til null-beregningseksperten at tokens kan velge og ikke gjøre noe, litt som en "vask" for enkle tokens.

> For lastbalansering har de et dsv3-lignende aux-tap gratis for å angi gjennomsnittlig ekte/falsk ekspert per token. De bruker en forfallsplan på denne skjevhetsoppdateringen. De gjør også tapsbalansekontroll.

2) Skalering

> De gjorde endringer i MLA/MoE for å ha variansjustering ved init. Gevinstene er ganske imponerende i figur 5, men jeg vet ikke i hvilken grad dette har innvirkning senere.

> Modellvekst init er ganske kult, de trener først en 2x mindre modell, og deretter "når den er trent nok" (litt uklart her hvor mange B-tokens) initerer de den endelige modellen ved å bare stable lagene til den mindre modellen.

> De brukte @_katieeverett @Locchiu og al. papir for å ha hyperparameteroverføring med SP i stedet for muP for den 2x mindre modellen ig.

3) Stabilitet

> De sporer Gradient Norm Ratio og cosinuslikhet mellom eksperter for å justere vekten av lastbalanseringstapet (de anbefaler Gradient Norm Ratio <0,1). > For å unngå store aktiveringer bruker de et z-tap på den skjulte tilstanden, med en ganske liten coef (et annet alternativ til qk-clip/norm).

> De setter Adam epsilon til 1e-16 og viser at du vil at den skal være lavere enn gradient RMS-området.

4) Andre

> De trener på 20T-tokens for fase 1, "multiple T of tokens" for midttrening på STEM/kodedata (70 % av blandingen), 100B for lang kontekstforlengelse uten garn (80B for 32k, 20B for 128k). De lange kontekstdokumentene representerer 25 % av blandingen (ikke sikker på om det er % av dokumenter eller tokens, noe som endrer mye her).

> Datapipeline før trening er kontekstutvinning, kvalitetsfiltrering, dedup.

> Nice-vedlegg der de viser at de sammenligner top_k som trengs for forskjellige benchmarks (høyere MMLU med 8.32, lavere GSM8K med 7.46). De sammenligner også tokenallokering i dype/grunne lag.

> De lanserer to nye benchmarks Meeseeks (multi-turn IF) og VitaBench (virkelig forretningsscenario).

> Mange detaljer i infra/inferens med informasjon om spekulativ dekodingsaksept, kvantisering, distribusjon, kjerneoptimalisering, coms-overlapping, etc.

> Liste over de forskjellige relevante papirene i tråden 🧵

14,23K

Topp

Rangering

Favoritter