Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BAILLEMENT 🥱

Même Meituan (entreprise d'application de livraison ~ DoorDash) expédie des LLM de pointe >> Meta. Le post que je cite ci-dessous décrit de nombreuses astuces techniques SOTA utilisées dans le modèle MoE de 560B.

Il y a des années, j'ai rencontré l'entraîneur de l'équipe IMO de la RPC à Pékin. Il m'a dit qu'ils pouvaient aligner plusieurs équipes de médaillés d'or chaque année s'ils le souhaitaient. La performance des équipes genAI en Chine le prouve - j'ai perdu le compte du nombre de modèles produits là-bas qui sont >> Meta et SOTA.

~La moitié des talents en IA dans le monde se trouve en Chine et la moitié des talents en IA aux États-Unis viennent de Chine.

Pour les Américains ignorants qui ne prennent pas la peine de suivre la plus grande et (sans doute) la plus innovante économie du monde :

Meituan (chinois : 美团 ; pinyin : Měituán, littéralement "groupe magnifique" ; anciennement Meituan–Dianping, littéralement "groupe magnifique–critiques") est une entreprise technologique chinoise qui propose une plateforme pour une large gamme de services locaux aux consommateurs, y compris la livraison de nourriture, les critiques de restaurants, les réservations de voyages et les services de vente au détail. L'entreprise est basée à Pékin et a été fondée en 2010 par Wang Xing.

31 août 2025

Le rapport technique de @Meituan_LongCat LongCat-Flash est incroyablement bon et plein de nouveautés.

Le modèle est un MoE passif de 560B ~27B actif avec un nombre adaptatif de paramètres actifs selon le contexte grâce à l'expert Zero-Computational.

1) Nouvelle architecture

> Les couches ont 2 blocs d'attention et à la fois FFN et MoE, de cette façon vous pouvez chevaucher les 2 communications all-to-all. (c'est aussi seulement 28 couches mais vous devez prendre en compte les 2 blocs d'attention).

> Ils ajoutent l'expert zero-computational que les tokens peuvent choisir et ne rien faire, un peu comme un "sink" pour les tokens faciles.

> Pour l'équilibrage de charge, ils ont une perte auxiliaire de type dsv3 libre pour définir la moyenne des experts réels/faux par token. Ils appliquent un calendrier de déclin à cette mise à jour de biais. Ils font également un contrôle de l'équilibre des pertes.

2) Mise à l'échelle

> Ils ont apporté des modifications à MLA/MoE pour avoir un alignement de variance à l'initialisation. Les gains sont assez impressionnants dans la Figure 5, mais je ne sais pas dans quelle mesure cela a un impact par la suite.

> L'initialisation de la croissance du modèle est plutôt cool, ils entraînent d'abord un modèle 2x plus petit et ensuite "quand il est suffisamment entraîné" (un peu flou ici combien de B tokens) ils initient le modèle final en empilant simplement les couches du modèle plus petit.

> Ils ont utilisé le papier de @_katieeverett @Locchiu et al. pour avoir un transfert d'hyperparamètres avec SP au lieu de muP pour le modèle 2x plus petit ig.

3) Stabilité

> Ils suivent le Ratio de Norme de Gradient et la similarité cosinus entre les experts pour ajuster le poids de la perte d'équilibrage de charge (ils recommandent un Ratio de Norme de Gradient <0.1).

> Pour éviter de grandes activations, ils appliquent une z-loss à l'état caché, avec un coef assez petit (une autre alternative à qk-clip/norm).

> Ils fixent l'epsilon d'Adam à 1e-16 et montrent que vous voulez qu'il soit inférieur à la plage RMS du gradient.

4) Autres

> Ils s'entraînent sur 20T tokens pour la phase 1, "plusieurs T de tokens" pour l'entraînement intermédiaire sur des données STEM/code (70% du mélange), 100B pour l'extension de contexte long sans fil (80B pour 32k, 20B pour 128k). Les documents de long contexte représentent 25% du mélange (pas sûr si c'est % de documents ou de tokens, ce qui change beaucoup ici).

> Le pipeline de données de pré-entraînement est extraction de contexte, filtrage de qualité, dé-duplication.

> Joli appendice où ils montrent qu'ils comparent le top_k nécessaire pour différents benchmarks (MMLU plus élevé avec 8.32, GSM8K plus bas avec 7.46). Ils comparent également l'allocation de tokens dans des couches profondes/peu profondes.

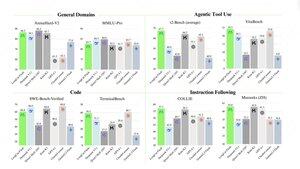

> Ils publient deux nouveaux benchmarks Meeseeks (IF multi-tour) et VitaBench (scénario commercial réel).

> Beaucoup de détails dans l'infrastructure/l'inférence avec des informations sur l'acceptation du décodage spéculatif, la quantification, le déploiement, l'optimisation du noyau, le chevauchement des communications, etc.

> Liste des différents papiers pertinents dans le fil 🧵

14,23K

Meilleurs

Classement

Favoris