Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

HAUKOTELLA 🥱

Jopa Meituan (toimitussovellusyritys ~ DoorDash) toimittaa raja-LLM:ää >> Metaa. Alla oleva lainaus Post I kuvaa monia 560B MoE -mallissa käytettyjä SOTA-teknisiä temppuja.

Vuosia sitten tapasin Kiinan IMO-joukkueen valmentajan Pekingissä. Hän kertoi minulle, että he voisivat halutessaan asettaa useita kultamitalistien joukkueita joka vuosi. Kiinan genAI-tiimien suorituskyky tukee tätä - olen menettänyt laskennan siellä tuotettujen mallien määrästä, jotka ovat >> Meta ja SOTA.

~Puolet maailman tekoälylahjakkuuksista on Kiinassa ja puolet yhdysvaltalaisesta tekoälylahjakkuudesta Kiinasta.

Tietämättömille amerikkalaisille, jotka eivät vaivaudu seuraamaan maailman suurinta ja (luultavasti) innovatiivisinta taloutta:

Meituan (kiinaksi: 美團; pinyin: Měituán, kirjaimellisesti "kaunis ryhmä"; entinen Meituan–Dianping, kirjaimellisesti "kaunis ryhmä-arvostelut") on kiinalainen teknologiayritys, joka tarjoaa alustan monenlaisille paikallisille kuluttajille, mukaan lukien ruoan toimitus, ravintola arvostelut, matkavaraukset ja vähittäismyyntipalvelut. Yrityksen pääkonttori sijaitsee Pekingissä, ja sen perusti vuonna 2010 Wang Xing.

23 tuntia sitten

@Meituan_LongCat LongCat-Flashin tekninen raportti on hullun hyvä ja täynnä uutuuksia.

Malli on 560B passiivinen ~27B aktiivinen MoE, jossa on mukautuva määrä aktiivisia parametreja kontekstista riippuen Zero-Computational-asiantuntijan ansiosta.

1) Uusi arkkitehtuuri

> Layersissa on 2 Attention-lohkoa ja sekä FFN että MoE, jolloin voit olla päällekkäin 2 all-to-all comin kanssa. (Lisäksi se on vain 28 kerrosta, mutta sinun on otettava huomioon 2 huomiolohkoa).

> He lisäävät nollalaskennan asiantuntijan, jonka tokenit voivat valita eivätkä tehdä mitään, ikään kuin "nielu" helpoille tokeneille.

> Kuormituksen tasapainottamista varten heillä on dsv3:n kaltainen aux-häviö, joka voi vapaasti asettaa keskimääräisen todellisen/väärennetyn asiantuntijan tokenia kohden. He soveltavat tähän harhapäivitykseen rappeutumisaikataulua. He tekevät myös häviösaldon hallinnan.

2) Skaalaus

> He tekivät muutoksia MLA/MoE:hen varianssin kohdistamiseksi initissä. Voitot ovat melko vaikuttavia kuviossa 5, mutta en tiedä, missä määrin tällä on vaikutusta myöhemmin.

> Mallin kasvu-init on aika siistiä, he kouluttavat ensin 2x pienemmän mallin ja sitten "kun se on koulutettu tarpeeksi" (hieman epäselvää tässä kuinka monta B-merkkiä) he aloittavat lopullisen mallin pinoamalla vain pienemmän mallin kerrokset.

> He käyttivät @_katieeverett @Locchiu- ja al. paperia hyperparametrien siirtoon SP:llä muP:n sijaan 2x pienemmässä mallissa ig.

3) Vakaus

> He seuraavat gradienttinormisuhdetta ja kosinisamankaltaisuutta asiantuntijoiden välillä säätääkseen kuormituksen tasapainotushäviön painoa (he suosittelevat gradienttinormisuhdetta <0,1). > Suurten aktivaatioiden välttämiseksi he kohdistavat z-häviön piilotilaan melko pienellä koeffilla (toinen vaihtoehto qk-clip/normille).

> He asettavat Adam epsilonin arvoon 1e-16 ja osoittavat, että haluat sen olevan pienempi kuin gradientin RMS-alue.

4) Muut

> He harjoittelevat 20T-tokeneilla vaiheessa 1, "useilla T-tokeneilla" STEM-/kooditietojen keskikoulutukseen (70 % seoksesta), 100B:llä pitkän kontekstin pidennykseen ilman lankaa (80B 32k:lle, 20B 128k:lle). Pitkän kontekstin asiakirjat edustavat 25 % seoksesta (en ole varma, onko se % asiakirjoista vai tokeneista, mikä muuttuu paljon tässä).

> Koulutusta edeltävä tietoputki on kontekstin poiminta, laadun suodatus ja dedup.

> Mukavan liitteen, jossa he osoittavat vertaavansa eri vertailuarvojen top_k (korkeampi MMLU 8,32, alhaisempi GSM8K 7,46). He vertaavat myös tokenien allokointia syvissä/matalissa kerroksissa.

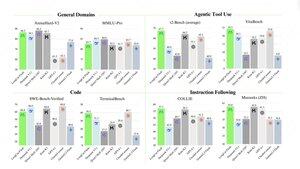

> He julkaisevat kaksi uutta vertailuarvoa: Meeseek (monikierros, IF) ja VitaBench (tosielämän liiketoimintaskenaario).

> Paljon yksityiskohtia infrassa/päättelyssä, jossa on tietoa spekulatiivisesta dekoodauksen hyväksymisestä, kvantisoinnista, käyttöönotosta, ytimen optimoinnista, coms-päällekkäisyydestä jne.

> Luettelo erilaisista asiaankuuluvista papereista langassa 🧵

11,93K

Johtavat

Rankkaus

Suosikit