Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ngáp 🥱

Ngay cả Meituan (công ty ứng dụng giao hàng ~ DoorDash) cũng vận chuyển LLM tiên tiến >> Meta. Bài đăng mà tôi trích dẫn dưới đây mô tả nhiều mẹo kỹ thuật SOTA được sử dụng trong mô hình 560B MoE.

Nhiều năm trước, tôi đã gặp huấn luyện viên của đội IMO Trung Quốc ở Bắc Kinh. Ông ấy nói với tôi rằng họ có thể cử nhiều đội huy chương vàng mỗi năm nếu họ muốn. Hiệu suất của các đội genAI ở Trung Quốc hỗ trợ điều này - tôi đã mất đếm số mô hình được sản xuất ở đó mà >> Meta và SOTA.

~Một nửa tài năng AI trên thế giới đang ở TRUNG QUỐC và một nửa tài năng AI của Mỹ đến từ Trung Quốc.

Đối với những người Mỹ không biết gì và không chịu theo dõi nền kinh tế lớn nhất và (có thể nói là) đổi mới nhất thế giới:

Meituan (tiếng Trung: 美团; pinyin: Měituán, nghĩa đen là "nhóm đẹp"; trước đây là Meituan–Dianping, nghĩa đen là "nhóm đẹp–đánh giá") là một công ty công nghệ Trung Quốc cung cấp nền tảng cho một loạt các dịch vụ tiêu dùng địa phương, bao gồm giao hàng thực phẩm, đánh giá nhà hàng, đặt chỗ du lịch và dịch vụ bán lẻ. Công ty có trụ sở tại Bắc Kinh và được thành lập vào năm 2010 bởi Wang Xing.

23 giờ trước

Báo cáo kỹ thuật của @Meituan_LongCat LongCat-Flash thật sự rất tuyệt vời và đầy tính mới mẻ.

Mô hình là một MoE thụ động 560B ~27B chủ động với số lượng tham số chủ động thích ứng tùy thuộc vào ngữ cảnh nhờ vào chuyên gia Zero-Computational.

1) Kiến trúc mới

> Các lớp có 2 khối Attention và cả FFN và MoE, như vậy bạn có thể chồng chéo 2 kết nối tất cả với tất cả. (cũng chỉ có 28 lớp nhưng bạn phải tính đến 2 khối attention).

> Họ thêm chuyên gia zero-computational mà các token có thể chọn và không làm gì, giống như một "bể" cho các token dễ dàng.

> Để cân bằng tải, họ có một tổn thất phụ giống như dsv3 miễn phí để thiết lập trung bình chuyên gia thật/giả cho mỗi token. Họ áp dụng một lịch trình suy giảm cho việc cập nhật thiên lệch này. Họ cũng thực hiện kiểm soát cân bằng tổn thất.

2) Mở rộng

> Họ đã thực hiện các thay đổi đối với MLA/MoE để có sự căn chỉnh phương sai tại khởi tạo. Những lợi ích khá ấn tượng trong Hình 5, nhưng tôi không biết mức độ ảnh hưởng của điều này sau này.

> Khởi tạo tăng trưởng mô hình khá thú vị, họ đầu tiên huấn luyện một mô hình nhỏ hơn 2x và sau đó "khi nó đã được huấn luyện đủ" (không rõ ở đây có bao nhiêu B token) họ khởi tạo mô hình cuối cùng bằng cách chỉ chồng các lớp của mô hình nhỏ hơn.

> Họ đã sử dụng bài báo của @_katieeverett @Locchiu và al. để có chuyển giao hyperparameter với SP thay vì muP cho mô hình nhỏ hơn 2x.

3) Ổn định

> Họ theo dõi Tỷ lệ Độ lớn Gradient và độ tương đồng cosine giữa các chuyên gia để điều chỉnh trọng số của tổn thất cân bằng tải (họ khuyên Tỷ lệ Độ lớn Gradient <0.1).

> Để tránh các kích hoạt lớn, họ áp dụng một tổn thất z cho trạng thái ẩn, với một hệ số khá nhỏ (một lựa chọn khác cho qk-clip/norm).

> Họ đặt epsilon Adam là 1e-16 và cho thấy rằng bạn muốn nó thấp hơn phạm vi RMS gradient.

4) Khác

> Họ huấn luyện trên 20T token cho giai đoạn 1, "nhiều T token" cho việc huấn luyện giữa trên dữ liệu STEM/code (70% của hỗn hợp), 100B cho mở rộng ngữ cảnh dài mà không có sợi (80B cho 32k, 20B cho 128k). Các tài liệu ngữ cảnh dài đại diện cho 25% của hỗn hợp (không chắc đây là % của tài liệu hay token, điều này thay đổi rất nhiều ở đây).

> Quy trình dữ liệu tiền huấn luyện là trích xuất ngữ cảnh, lọc chất lượng, loại bỏ trùng lặp.

> Phụ lục đẹp nơi họ cho thấy họ so sánh top_k cần thiết cho các tiêu chuẩn khác nhau (MMLU cao hơn với 8.32, GSM8K thấp hơn với 7.46). Họ cũng so sánh phân bổ token trong các lớp sâu/nông.

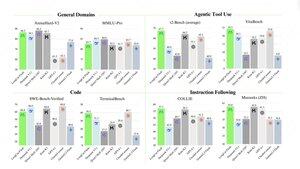

> Họ phát hành hai tiêu chuẩn mới Meeseeks (nhiều lượt IF) và VitaBench (kịch bản kinh doanh thực tế).

> Nhiều chi tiết trong hạ tầng/giải mã với thông tin về chấp nhận giải mã suy đoán, lượng tử hóa, triển khai, tối ưu hóa kernel, chồng chéo kết nối, v.v.

> Danh sách các tài liệu liên quan khác trong chuỗi 🧵

11,92K

Hàng đầu

Thứ hạng

Yêu thích