Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ЗЕВНУ 🥱

Даже Meituan (компания по доставке ~ DoorDash) отправляет передовые LLM >> Meta. Пост, который я цитирую ниже, описывает множество SOTA технических трюков, использованных в модели 560B MoE.

Несколько лет назад я встретился с тренером команды IMO КНР в Пекине. Он сказал мне, что они могли бы выставлять несколько команд золотых медалистов каждый год, если бы захотели. Производительность команд genAI в Китае подтверждает это - я потерял счет количеству моделей, произведенных там, которые >> Meta и SOTA.

~Половина AI-талантов в мире находится В Китае, а половина AI-талантов США - ИЗ Китая.

Для неосведомленных американцев, которые не утруждают себя следить за крупнейшей и (возможно) самой инновационной экономикой в мире:

Meituan (китайский: 美团; пиньинь: Měituán, буквально "красивый коллектив"; ранее Meituan–Dianping, буквально "красивый коллектив–отзывы") - это китайская технологическая компания, которая предлагает платформу для широкого спектра местных потребительских услуг, включая доставку еды, отзывы о ресторанах, бронирование путешествий и розничные услуги. Компания имеет штаб-квартиру в Пекине и была основана в 2010 году Ван Сином.

23 часа назад

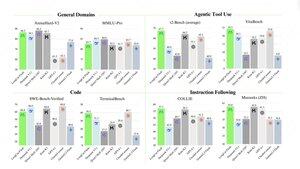

Технический отчет @Meituan_LongCat LongCat-Flash просто потрясающий и полон новизны.

Модель представляет собой 560B пассивный ~27B активный MoE с адаптивным количеством активных параметров в зависимости от контекста благодаря нулевому вычислительному эксперту.

1) Новая архитектура

> Слои имеют 2 блока внимания и как FFN, так и MoE, таким образом, вы можете перекрывать 2 всех-в-одном соединения. (также это всего 28 слоев, но нужно учитывать 2 блока внимания).

> Они добавляют нулевой вычислительный эксперт, который токены могут выбирать и ничего не делать, что-то вроде "слива" для простых токенов.

> Для балансировки нагрузки у них есть aux loss, похожая на dsv3, свободная для установки среднего реального/фальшивого эксперта на токен. Они применяют график затухания для этого обновления смещения. Они также контролируют баланс потерь.

2) Масштабирование

> Они внесли изменения в MLA/MoE, чтобы иметь выравнивание дисперсии при инициализации. Увеличения довольно впечатляющие на рисунке 5, но я не знаю, в какой степени это повлияет позже.

> Инициализация роста модели довольно интересна, сначала они обучают модель в 2 раза меньшего размера, а затем "когда она достаточно обучена" (здесь немного неясно, сколько B токенов) они инициализируют финальную модель, просто складывая слои меньшей модели.

> Они использовали статью @_katieeverett @Locchiu и др. для передачи гиперпараметров с SP вместо muP для модели в 2 раза меньшего размера.

3) Стабильность

> Они отслеживают отношение нормы градиента и косинусное сходство между экспертами, чтобы корректировать вес потерь балансировки нагрузки (рекомендуют, чтобы отношение нормы градиента было <0.1).

> Чтобы избежать больших активаций, они применяют z-loss к скрытому состоянию с довольно маленьким коэффициентом (другая альтернатива qk-clip/norm).

> Они устанавливают epsilon для Adam на 1e-16 и показывают, что он должен быть ниже диапазона RMS градиента.

4) Прочее

> Они обучают на 20T токенов для фазы 1, "несколько T токенов" для промежуточного обучения на STEM/кодовых данных (70% смеси), 100B для расширения длинного контекста без пряжи (80B для 32k, 20B для 128k). Длинные контекстные документы составляют 25% смеси (не уверен, является ли это % документов или токенов, что здесь сильно меняется).

> Конвейер данных для предварительного обучения включает извлечение контекста, фильтрацию качества, дедупликацию.

> Приятное приложение, где они показывают, что сравнивают top_k, необходимый для различных бенчмарков (более высокий MMLU с 8.32, более низкий GSM8K с 7.46). Они также сравнивают распределение токенов в глубоких/мелких слоях.

> Они выпускают два новых бенчмарка Meeseeks (многоходовые IF) и VitaBench (сценарий реального бизнеса).

> Много деталей в инфраструктуре/инференсе с информацией о принятии спекулятивного декодирования, квантовании, развертывании, оптимизации ядра, перекрытии соединений и т.д.

> Список различных релевантных статей в треде 🧵

11,92K

Топ

Рейтинг

Избранное