Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GÄSPA 🥱

Till och med Meituan (leveransappföretag ~ DoorDash) skickar frontier LLM >> Meta. Citat från inlägg I nedan beskriver många SOTA-tekniska knep som används i 560B MoE-modellen.

För flera år sedan träffade jag tränaren för Kinas IMO-lag i Peking. Han berättade för mig att de kunde ställa upp med flera lag med guldmedaljörer varje år om de ville. Prestandan hos genAI-team i Kina stöder detta - jag har tappat räkningen på antalet modeller som produceras där som är >> Meta och SOTA.

~ Hälften av AI-talangerna i världen finns i Kina och hälften av USA:s AI-talanger kommer från Kina.

För aningslösa amerikaner som inte bryr sig om att följa den största och (utan tvekan) mest innovativa ekonomin i världen:

Meituan (kinesiska: 美團; pinyin: Měituán, bokstavligen "vacker grupp"; tidigare Meituan–Dianping, bokstavligen "vacker grupp–recensioner") är ett kinesiskt teknikföretag som erbjuder en plattform för ett brett utbud av lokala konsumenter, inklusive matleveranser, restaurang recensioner, resebokningar och detaljhandelstjänster. Företaget har sitt huvudkontor i Peking och grundades 2010 av Wang Xing.

23 timmar sedan

Den tekniska rapporten från @Meituan_LongCat LongCat-Flash är galet bra och full av nyheter.

Modellen är en 560B passiv ~27B aktiv MoE med adaptivt antal aktiva parametrar beroende på sammanhanget tack vare Zero-Computational-experten.

1) Ny arkitektur

> lager har 2 uppmärksamhetsblock och både FFN och MoE, på så sätt kan du överlappa de 2 allt-till-alla-kommen. (Dessutom är det bara 28 lager men du måste ta hänsyn till de 2 uppmärksamhetsblocken).

> De lägger till experten på nollberäkning som tokens kan välja och inte göra någonting, ungefär som en "sink" för enkla tokens.

> För lastbalansering har de en dsv3-liknande aux loss free för att ställa in den genomsnittliga riktiga/falska experten per token. De tillämpar ett förfallsschema på den här biasuppdateringen. De gör också kontroll av förlustbalansen.

2) Skalning

> De gjorde ändringar i MLA/MoE för att ha variansjustering vid init. Vinsterna är ganska imponerande i figur 5, men jag vet inte i vilken utsträckning detta har inverkan senare.

> Modelltillväxt är ganska coolt, de tränar först en 2x mindre modell och sedan "när den är tillräckligt tränad" (lite oklart här hur många B-tokens) de initierar den slutliga modellen genom att bara stapla lagren i den mindre modellen.

> De använde @_katieeverett @Locchiu och al. papper för att ha hyperparameteröverföring med SP istället för muP för den 2x mindre modellen ig.

3) Stabilitet

> De spårar Gradient Norm Ratio och cosinuslikhet mellan experter för att justera vikten på lastbalanseringsförlusten (de rekommenderar Gradient Norm Ratio <0,1). > För att undvika stora aktiveringar applicerar de en z-förlust på det dolda tillståndet, med en ganska liten coef (ett annat alternativ till qk-clip/norm).

> De ställer in Adam epsilon till 1e-16 och visar att du vill att den ska vara lägre än gradient-RMS-intervallet.

4) Övrigt

> De tränar på 20T-tokens för fas 1, "flera T av tokens" för mellanträning på STEM/koddata (70 % av blandningen), 100B för lång kontextförlängning utan garn (80B för 32k, 20B för 128k). De långa kontextdokumenten representerar 25 % av blandningen (inte säker på om det är % av dokumenten eller token, vilket ändras mycket här).

> Datapipeline före träning är kontextextrahering, kvalitetsfiltrering, deduplicering.

> Nice-bilaga där de visar att de jämför top_k som behövs för olika benchmarks (högre MMLU med 8,32, lägre GSM8K med 7,46). De jämför också tokenallokering i djupa/grunda lager.

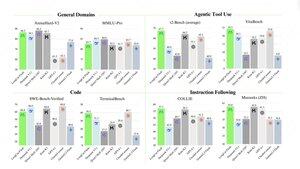

> De släpper två nya benchmarks: Meeseeks (multi-turn IF) och VitaBench (real-world business scenario).

> Massor av detaljer i infra/inferens med information om spekulativ avkodningsacceptans, kvantisering, distribution, kärnoptimering, coms-överlappning, etc.

> Lista över de olika relevanta papperen i tråden 🧵

11,93K

Topp

Rankning

Favoriter