熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

打哈欠 🥱

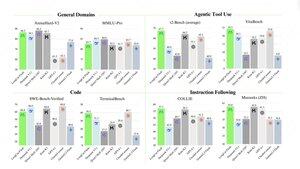

甚至美團(外賣應用公司 ~ DoorDash)也在前沿 LLM 方面超越了 Meta。以下我引用的帖子描述了在 560B MoE 模型中使用的許多 SOTA 技術技巧。

幾年前,我在北京與中國 IMO 團隊的教練見面。他告訴我,如果他們想的話,每年可以派出多支金牌團隊。中國的 genAI 團隊的表現支持了這一點——我已經數不清那裡的模型數量,它們都超越了 Meta 和 SOTA。

世界上大約一半的 AI 人才在中國,而美國的 AI 人才中有一半來自中國。

對於那些不願意關注世界上最大且(可以說)最具創新性的經濟體的無知美國人:

美團(中文:美團;拼音:Měituán,字面意思是“美麗的團體”;前稱美團–點評,字面意思是“美麗的團體–評論”)是一家中國科技公司,提供廣泛的本地消費平台,包括外賣、餐廳評論、旅行預訂和零售服務。該公司總部位於北京,成立於2010年,由王興創辦。

22 小時前

@Meituan_LongCat 的 LongCat-Flash 技術報告非常出色,充滿了新穎性。

該模型是一個 560B 被動 ~27B 活動 MoE,具有根據上下文自適應的活動參數數量,這要歸功於零計算專家。

1) 新架構

> 層具有 2 個注意力塊,同時包含 FFN 和 MoE,這樣可以重疊這兩個全連接通信。(雖然只有 28 層,但必須考慮到 2 個注意力塊)。

> 他們添加了零計算專家,令標記可以選擇並不做任何事情,有點像“水槽”用於簡單標記。

> 為了負載均衡,他們有一個類似 dsv3 的輔助損失,可以自由設置每個標記的真實/虛假專家的平均值。他們對這個偏差更新應用了衰減計劃。他們還進行了損失平衡控制。

2) 擴展

> 他們對 MLA/MoE 進行了更改,以在初始化時實現方差對齊。圖 5 中的增益相當令人印象深刻,但我不知道這在後期會產生多大影響。

> 模型增長初始化相當酷,他們首先訓練一個小 2 倍的模型,然後“當它訓練得足夠好時”(這裡不太清楚需要多少 B 個標記)通過簡單堆疊小模型的層來初始化最終模型。

> 他們使用了 @_katieeverett @Locchiu 等人的論文,通過 SP 而不是 muP 進行超參數轉移,以適應 2 倍小的模型。

3) 穩定性

> 他們跟蹤梯度範數比和專家之間的餘弦相似度,以調整負載均衡損失的權重(他們建議梯度範數比 <0.1)。

> 為了避免大激活,他們對隱藏狀態應用了 z-loss,係數相當小(這是 qk-clip/norm 的另一種替代方案)。

> 他們將 Adam 的 epsilon 設置為 1e-16,並表明希望其低於梯度 RMS 範圍。

4) 其他

> 他們在階段 1 上訓練了 20T 個標記,在 STEM/code 數據上進行中期訓練時“多個 T 的標記”(混合物的 70%),在沒有紗線的情況下進行長上下文擴展時為 100B(32k 為 80B,128k 為 20B)。長上下文文檔占混合物的 25%(不確定這是文檔的百分比還是標記的百分比,這裡變化很大)。

> 預訓練數據管道是上下文提取、質量過濾、去重。

> 附錄中很好地展示了他們比較不同基準所需的 top_k(MMLU 較高為 8.32,GSM8K 較低為 7.46)。他們還比較了深層/淺層的標記分配。

> 他們發布了兩個新的基準 Meeseeks(多輪 IF)和 VitaBench(現實世界商業場景)。

> 在基礎設施/推理方面有很多細節,包括關於投機解碼接受、量化、部署、內核優化、通信重疊等的信息。

> 線程中列出了不同的相關論文 🧵

11.92K

熱門

排行

收藏