Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GAAAP 🥱

Zelfs Meituan (bezorgapp bedrijf ~ DoorDash) verzendt frontier LLM >> Meta. De post die ik hieronder citeer beschrijft veel SOTA technische trucs die worden gebruikt in het 560B MoE-model.

Jaren geleden ontmoette ik de coach van het PRC IMO-team in Beijing. Hij vertelde me dat ze elk jaar meerdere teams van gouden medaillewinnaars konden inzetten als ze dat wilden. De prestaties van genAI-teams in China ondersteunen dit - ik ben de tel kwijtgeraakt van het aantal modellen dat daar is geproduceerd dat >> Meta en SOTA is.

~De helft van het AI-talent in de wereld is IN China en de helft van het AI-talent in de VS is VAN China.

Voor onwetende Amerikanen die het niet de moeite waard vinden om de grootste en (mogelijk) meest innovatieve economie ter wereld te volgen:

Meituan (Chinees: 美团; pinyin: Měituán, letterlijk "mooie groep"; voorheen Meituan–Dianping, letterlijk "mooie groep–recensies") is een Chinees technologiebedrijf dat een platform biedt voor een breed scala aan lokale consumenten, waaronder voedselbezorging, restaurantrecensies, reisboekingen en retaildiensten. Het bedrijf is gevestigd in Beijing en werd in 2010 opgericht door Wang Xing.

23 uur geleden

Het technische rapport van @Meituan_LongCat LongCat-Flash is waanzinnig goed en vol nieuwigheden.

Het model is een 560B passief ~27B actief MoE met een adaptief aantal actieve parameters afhankelijk van de context, dankzij de Zero-Computational expert.

1) Nieuwe architectuur

> Laag hebben 2 Attention-blokken en zowel FFN als MoE, zodat je de 2 all-to-all communicatie kunt overlappen. (ook al zijn het maar 28 lagen, maar je moet de 2 attention-blokken in overweging nemen).

> Ze voegen de zero-computational expert toe waar tokens voor kunnen kiezen en niets doen, een beetje zoals een "sink" voor gemakkelijke tokens.

> Voor load balancing hebben ze een dsv3-achtige aux loss die vrij is om het gemiddelde echte/nep expert per token in te stellen. Ze passen een vervalplanning toe op deze bias-update. Ze doen ook verliesbalanscontrole.

2) Schaling

> Ze hebben wijzigingen aangebracht in MLA/MoE om variantie-alignment bij init te hebben. De winsten zijn behoorlijk indrukwekkend in Figuur 5, maar ik weet niet in hoeverre dit later impact heeft.

> De initiële modelgroei is behoorlijk cool, ze trainen eerst een 2x kleiner model en dan "wanneer het genoeg getraind is" (een beetje onduidelijk hier hoeveel B tokens) initieren ze het uiteindelijke model door gewoon de lagen van het kleinere model te stapelen.

> Ze hebben het paper van @_katieeverett @Locchiu en anderen gebruikt om hyperparameteroverdracht met SP in plaats van muP voor het 2x kleinere model te hebben.

3) Stabiliteit

> Ze volgen de Gradient Norm Ratio en de cosinus-similariteit tussen experts om het gewicht van de load balancing-verlies aan te passen (ze raden aan om de Gradient Norm Ratio <0.1 te houden).

> Om grote activaties te vermijden, passen ze een z-verlies toe op de verborgen toestand, met een vrij kleine coef (een andere alternatieve voor qk-clip/norm).

> Ze stellen Adam epsilon in op 1e-16 en tonen aan dat je wilt dat het lager is dan het gradient RMS-bereik.

4) Overige

> Ze trainen op 20T tokens voor fase 1, "meerdere T tokens" voor tussentijdse training op STEM/code data (70% van de mix), 100B voor lange contextuitbreiding zonder garen (80B voor 32k, 20B voor 128k). De lange contextdocumenten vertegenwoordigen 25% van de mix (niet zeker of het % van documenten of tokens is, wat hier veel verandert).

> De pre-trainingsdatapijplijn is contextextractie, kwaliteitsfiltering, deduplicatie.

> Mooie bijlage waar ze laten zien dat ze top_k vergelijken die nodig zijn voor verschillende benchmarks (hogere MMLU met 8.32, lagere GSM8K met 7.46). Ze vergelijken ook tokenallocatie in diepe/ondiepe lagen.

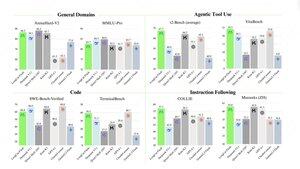

> Ze brengen twee nieuwe benchmarks uit: Meeseeks (multi-turn IF) en VitaBench (real-world business scenario).

> Veel details in de infra/inferentie met info over speculatieve decoderingacceptatie, kwantisatie, implementatie, kerneloptimalisatie, overlappende communicatie, enz.

> Lijst van de verschillende relevante papers in de thread 🧵

11,93K

Boven

Positie

Favorieten