Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ПОЗІХАННЯ 🥱

Навіть Meituan (компанія, що займається розробкою додатків для доставки ~ DoorDash) відправляє прикордонні LLM >> Meta. Пост, який я цитую нижче, описує багато технічних хитрощів SOTA, які використовуються в моделі 560B MoE.

Багато років тому я зустрічався з тренером збірної КНР IMO в Пекіні. Він сказав мені, що вони можуть виставляти кілька команд золотих медалістів щороку, якщо захочуть. Продуктивність команд genAI в Китаї підтверджує це - я збився з ліку кількості вироблених там моделей, які є >> Meta і SOTA.

~ Половина талантів у галузі штучного інтелекту у світі знаходиться в Китаї, а половина талантів у галузі штучного інтелекту в США – З Китаю.

Для нетямущих американців, які не турбуються про те, щоб стежити за найбільшою та (можливо) найбільш інноваційною економікою у світі:

Мейтуань (кит. 美團; піньїнь: Měituán, дослівно «красива група»; раніше Meituan–Dianping, буквально «красива група – відгуки») — китайська технологічна компанія, яка пропонує платформу для широкого кола місцевих споживачів, включаючи доставку їжі, ресторани відгуки, бронювання подорожей та роздрібні послуги. Штаб-квартира компанії знаходиться в Пекіні і була заснована в 2010 році Ван Сіном.

22 години тому

Технічний звіт @Meituan_LongCat LongCat-Flash шалено хороший і сповнений новизни.

Модель являє собою пасивний активний MoE 560B ~ 27B з адаптивною кількістю активних параметрів в залежності від контексту завдяки експерту Zero-Computational.

1) Нова архітектура

> Layers мають 2 блоки уваги та FFN і MoE, таким чином ви можете перекрити 2 коми «все до всього». (також це всього 28 шарів, але ви повинні враховувати 2 блоки уваги).

> Вони додають експерта з нульових обчислень, що токени можуть вибирати і нічого не робити, щось на кшталт «раковини» для легких токенів.

> Для балансування навантаження вони мають DSV3-подібний безкоштовний AUX-loss, щоб встановити середнього реального/фальшивого експерта на токен. Вони застосовують графік розпаду до цього оновлення упередженості. Вони також контролюють баланс втрат.

2) Масштабування

> Вони внесли зміни до MLA/MoE, щоб мати вирівнювання дисперсії під час ініціалізації. На рисунку 5 успіхи досить вражаючі, але я не знаю, наскільки це вплине на подальші події.

> Зростання моделі вце досить круто, вони спочатку тренують модель у 2 рази менше, а потім «коли вона достатньо навчена» (тут трохи незрозуміло, скільки токенів B) вони вводять остаточну модель, просто складаючи шари меншої моделі.

> Вони використовували папір @_katieeverett @Locchiu та al. для перенесення гіперпараметрів з SP замість muP для 2x меншої моделі ig.

3) Стабільність

> Вони відстежують коефіцієнт градієнтної норми та подібність косинусів між експертами для коригування ваги втрати балансування навантаження (вони рекомендують коефіцієнт градієнтної норми <0,1). > Щоб уникнути великих активацій, вони застосовують z-втрату до прихованого стану, з досить маленьким коефом (ще одна альтернатива qk-clip/norm).

> Вони встановили Adam epsilon на 1e-16 і показують, що ви хочете, щоб він був нижчим за діапазон градієнтного середньоквадратичного значення.

4) Інше

> Вони тренуються на 20T токенах для фази 1, «кілька T токенів» для середнього тренування на даних STEM/коду (70% суміші), 100B для подовження довгого контексту без пряжі (80B для 32k, 20B для 128k). Документи з довгим контекстом становлять 25% суміші (не впевнений, чи це % документів, чи токени, що тут сильно змінюється).

> Попереднє навчання конвеєра даних – це вилучення контексту, фільтрація якості, дедап.

> Гарний додаток, де вони показують, що порівнюють top_k необхідні для різних бенчмарків (вищий MMLU – 8,32, нижчий GSM8K – 7,46). Вони також порівнюють розподіл токенів у глибоких/неглибоких шарах.

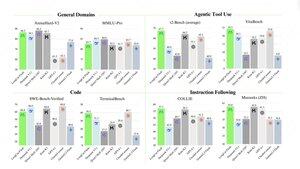

> Вони випускають два нових бенчмарки: Meeseeks (багатооборотний IF) і VitaBench (реальний бізнес-сценарій).

> Багато деталей в інфраструктурі/висновку з інформацією про прийняття спекулятивного декодування, квантування, розгортання, оптимізацію ядра, перекриття комів тощо.

> Список різних релевантних паперів в нитках 🧵

11,91K

Найкращі

Рейтинг

Вибране