Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GÄHN 🥱

Selbst Meituan (Liefer-App-Unternehmen ~ DoorDash) versendet an der Spitze LLM >> Meta. Der Beitrag, den ich unten zitiere, beschreibt viele SOTA technische Tricks, die im 560B MoE-Modell verwendet werden.

Vor Jahren traf ich den Trainer des PRC IMO-Teams in Peking. Er sagte mir, sie könnten jedes Jahr mehrere Teams von Goldmedaillengewinnern aufstellen, wenn sie wollten. Die Leistung der genAI-Teams in China unterstützt dies - ich habe die Anzahl der dort produzierten Modelle, die >> Meta und SOTA sind, aus den Augen verloren.

~Die Hälfte des KI-Talents der Welt ist IN China und die Hälfte des US-KI-Talents stammt AUS China.

Für ahnungslose Amerikaner, die sich nicht die Mühe machen, die größte und (arguably) innovativste Wirtschaft der Welt zu verfolgen:

Meituan (Chinesisch: 美团; Pinyin: Měituán, wörtlich "schöne Gruppe"; früher Meituan–Dianping, wörtlich "schöne Gruppe–Bewertungen") ist ein chinesisches Technologieunternehmen, das eine Plattform für eine Vielzahl von lokalen Verbraucherdiensten anbietet, einschließlich Essenslieferung, Restaurantbewertungen, Reisebuchungen und Einzelhandelsdiensten. Das Unternehmen hat seinen Hauptsitz in Peking und wurde 2010 von Wang Xing gegründet.

Vor 23 Stunden

Der technische Bericht von @Meituan_LongCat LongCat-Flash ist verrückt gut und voller Neuheiten.

Das Modell ist ein 560B passives ~27B aktives MoE mit einer adaptiven Anzahl aktiver Parameter, die je nach Kontext dank des Zero-Computational-Experten variieren.

1) Neue Architektur

> Die Schichten haben 2 Attention-Blöcke und sowohl FFN als auch MoE, sodass Sie die beiden All-to-All-Kommunikationen überlappen können. (Es sind auch nur 28 Schichten, aber Sie müssen die 2 Attention-Blöcke berücksichtigen).

> Sie fügen den Zero-Computational-Experten hinzu, den Tokens wählen können und der nichts tut, ähnlich wie ein "Sink" für einfache Tokens.

> Für das Lastenbalancing haben sie einen dsv3-ähnlichen Hilfsverlust, um die durchschnittlichen echten/falschen Experten pro Token frei festzulegen. Sie wenden einen Abbauzeitplan auf dieses Bias-Update an. Sie führen auch eine Verlustausgleichskontrolle durch.

2) Skalierung

> Sie haben Änderungen an MLA/MoE vorgenommen, um eine Variationsausrichtung bei der Initialisierung zu haben. Die Gewinne sind in Abbildung 5 ziemlich beeindruckend, aber ich weiß nicht, inwieweit dies später Auswirkungen hat.

> Das Wachstum des Modells bei der Initialisierung ist ziemlich cool, sie trainieren zuerst ein 2x kleineres Modell und dann "wenn es genug trainiert ist" (hier ist unklar, wie viele B Tokens) initialisieren sie das endgültige Modell, indem sie einfach die Schichten des kleineren Modells stapeln.

> Sie verwendeten das Papier von @_katieeverett @Locchiu und anderen, um den Hyperparametertransfer mit SP anstelle von muP für das 2x kleinere Modell zu haben.

3) Stabilität

> Sie verfolgen das Gradientennormverhältnis und die Kosinusähnlichkeit zwischen den Experten, um das Gewicht des Lastenbalancingverlusts anzupassen (sie empfehlen ein Gradientennormverhältnis <0.1).

> Um große Aktivierungen zu vermeiden, wenden sie einen z-Verlust auf den versteckten Zustand an, mit einem ziemlich kleinen Koeffizienten (eine weitere Alternative zu qk-clip/norm).

> Sie setzen Adam-Epsilon auf 1e-16 und zeigen, dass es niedriger als der Gradient-RMS-Bereich sein sollte.

4) Sonstiges

> Sie trainieren mit 20T Tokens für Phase 1, "mehrere T Tokens" für das mittlere Training mit STEM/code-Daten (70% der Mischung), 100B für die Erweiterung des langen Kontexts ohne Garn (80B für 32k, 20B für 128k). Die langen Kontextdokumente machen 25% der Mischung aus (nicht sicher, ob es % der Dokumente oder Tokens sind, was hier viel ändert).

> Die Pipeline für die Vorverarbeitung der Daten besteht aus Kontextextraktion, Qualitätsfilterung, Dedup.

> Schöner Anhang, in dem sie zeigen, dass sie top_k für verschiedene Benchmarks vergleichen (höheres MMLU mit 8.32, niedrigeres GSM8K mit 7.46). Sie vergleichen auch die Token-Zuweisung in tiefen/flachen Schichten.

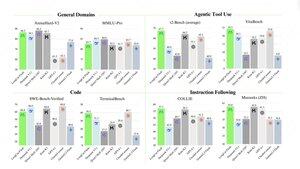

> Sie veröffentlichen zwei neue Benchmarks Meeseeks (Multi-Turn IF) und VitaBench (realistische Geschäftsszenarien).

> Viele Details in der Infrastruktur/Inference mit Informationen zur Akzeptanz der spekulativen Dekodierung, Quantisierung, Bereitstellung, Kernel-Optimierung, überlappenden Kommunikationen usw.

> Liste der verschiedenen relevanten Papiere im Thread 🧵

11,92K

Top

Ranking

Favoriten