Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ziewam 🥱

Nawet Meituan (firma zajmująca się dostawami ~ DoorDash) wysyła frontier LLM >> Meta. Post, który cytuję poniżej, opisuje wiele SOTA technicznych sztuczek używanych w modelu 560B MoE.

Lata temu spotkałem się z trenerem drużyny IMO z PRC w Pekinie. Powiedział mi, że mogliby wystawić wiele drużyn złotych medalistów każdego roku, jeśli by chcieli. Wyniki zespołów genAI w Chinach to potwierdzają - straciłem rachubę modeli produkowanych tam, które są >> Meta i SOTA.

~Połowa talentów AI na świecie jest W Chinach, a połowa talentów AI w USA pochodzi Z Chin.

Dla nieświadomych Amerykanów, którzy nie zadają sobie trudu, aby śledzić największą i (można argumentować) najbardziej innowacyjną gospodarkę na świecie:

Meituan (chiński: 美团; pinyin: Měituán, dosłownie "piękna grupa"; wcześniej Meituan–Dianping, dosłownie "piękna grupa–recenzje") to chińska firma technologiczna, która oferuje platformę dla szerokiego zakresu lokalnych konsumentów, w tym dostaw jedzenia, recenzji restauracji, rezerwacji podróży i usług detalicznych. Firma ma siedzibę w Pekinie i została założona w 2010 roku przez Wanga Xinga.

31 sie 2025

Raport techniczny @Meituan_LongCat LongCat-Flash jest niesamowity i pełen nowości.

Model to 560B pasywny ~27B aktywny MoE z adaptacyjną liczbą aktywnych parametrów w zależności od kontekstu dzięki Zero-Computational expert.

1) Nowa architektura

> Warstwy mają 2 bloki uwagi i zarówno FFN, jak i MoE, dzięki czemu można nałożyć na siebie 2 połączenia all-to-all. (to tylko 28 warstw, ale trzeba wziąć pod uwagę 2 bloki uwagi).

> Dodają zero-computational expert, który tokeny mogą wybierać i nic nie robić, coś jak "sink" dla łatwych tokenów.

> W celu równoważenia obciążenia mają aux loss podobny do dsv3, który można ustawić na średnią rzeczywistą/fałszywą ekspert per token. Stosują harmonogram wygaszania do tej aktualizacji biasu. Robią również kontrolę równowagi strat.

2) Skalowanie

> Wprowadzili zmiany w MLA/MoE, aby mieć wyrównanie wariancji na początku. Zyski są dość imponujące na Rysunku 5, ale nie wiem, w jakim stopniu ma to wpływ później.

> Inicjacja wzrostu modelu jest całkiem fajna, najpierw trenują model 2x mniejszy, a potem "gdy jest wystarczająco wytrenowany" (trochę niejasne, ile B tokenów) inicjują model końcowy, po prostu układając warstwy mniejszego modelu.

> Użyli pracy @_katieeverett @Locchiu i in. do transferu hiperparametrów z SP zamiast muP dla 2x mniejszego modelu.

3) Stabilność

> Śledzą stosunek normy gradientu i podobieństwo cosinusowe między ekspertami, aby dostosować wagę straty równoważenia obciążenia (zalecają stosunek normy gradientu <0.1).

> Aby uniknąć dużych aktywacji, stosują z-loss do stanu ukrytego, z dość małym współczynnikiem (inna alternatywa dla qk-clip/norm).

> Ustawiają epsilon Adama na 1e-16 i pokazują, że powinien być niższy niż zakres RMS gradientu.

4) Inne

> Trenują na 20T tokenów w fazie 1, "wiele T tokenów" w trakcie treningu na danych STEM/kod (70% mieszanki), 100B na długie rozszerzenie kontekstu bez przędzy (80B dla 32k, 20B dla 128k). Długie dokumenty kontekstowe stanowią 25% mieszanki (nie jestem pewien, czy to % dokumentów, czy tokenów, co tutaj dużo zmienia).

> Pipeline danych do wstępnego treningu to ekstrakcja kontekstu, filtrowanie jakości, deduplikacja.

> Fajny dodatek, w którym pokazują, że porównują top_k potrzebne do różnych benchmarków (wyższe MMLU z 8.32, niższe GSM8K z 7.46). Porównują również alokację tokenów w głębokich/płytkich warstwach.

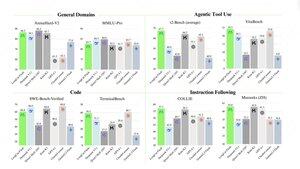

> Wydają dwa nowe benchmarki Meeseeks (wieloturnowe IF) i VitaBench (scenariusz biznesowy w rzeczywistości).

> Wiele szczegółów w infrastrukturze/inferencji z informacjami na temat akceptacji dekodowania spekulacyjnego, kwantyzacji, wdrożenia, optymalizacji jądra, nakładania się połączeń itp.

> Lista różnych istotnych prac w wątku 🧵

14,23K

Najlepsze

Ranking

Ulubione