Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

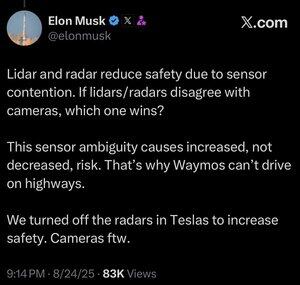

Meer data is niet altijd beter.

Wanneer een geautomatiseerd systeem snel een beslissing moet nemen, wil je dat het de meest beknopte set relevante gegevens heeft die nodig zijn om de juiste keuze te maken.

Meer dingen analyseren maakt je gewoon trager.

Je kunt dit bij mensen zien. Het veld van kunstmatige intelligentie kopieert voor altijd de huiswerkopdrachten van de evolutie, en met goede reden. Waarom al die miljoenen jaren aan opkomende resultaten weggooien en opnieuw vanaf nul beginnen?

Mensen hebben eigenlijk geen vijf zintuigen (meer zoals ongeveer 22), maar één ding dat we niet veel zien in die zintuigen is overlap.

Het lijkt erop dat het evolutionaire proces steeds weer de notie heeft ontdekt dat het beter is om je ogen fijn af te stemmen op wat je moet zien, in plaats van twee of drie verschillende soorten ogen te ontwikkelen om naar hetzelfde te kijken.

Natuurlijk zijn multi-channel benaderingen niet onmogelijk, en misschien kan een lidar-systeem alleen werkend worden gemaakt.

Maar het ding van het gebruik van camera's die vergelijkbaar zijn met het menselijk zicht, is dat je kunt putten uit alles wat we weten over het menselijk zicht.

En als je dat gebruikt om auto's te besturen, dan kun je putten uit alles wat we weten of kunnen ontdekken over hoe mensen auto's besturen.

Als je een soort ingenieur bent, is dit een no-brainer, en, ondanks wat Lexxie misschien denkt, of doet alsof ze denkt terwijl de camera's draaien, is Elon Musk 100% ingenieur en heel weinig anders, en elke andere ingenieur kan dit gewoon al zien aan hoe hij praat.

Lidar is goed voor veel dingen, waarschijnlijk ook voor ruimtevaartuigen, maar als je het in een auto plaatst, is het gewoon een publieke erkenning dat je de vaardigheden niet hebt, of gewoon niet de moeite hebt genomen, om de AI-capaciteit te ontwikkelen om een camera op iets te richten en echt te karakteriseren wat je bekijkt.

25 aug, 13:59

Ik weet niet zeker of dit logisch is. Toegegeven, Elon is veel slimmer dan ik, maar hier zijn mijn 2 cent:

Ik denk niet dat sensorfusie onmogelijk is, het maakt het systeem gewoon veel ingewikkelder. Ik kan een object zien, het aanraken, het ruiken, en mijn brein kan dat allemaal natuurlijk samenvoegen. Ik denk niet dat sensorfusie inherent minder veilig is, maar het verhoogt de complexiteit van het systeem en vergroot het aantal faalpunten. Het belangrijkste probleem van Tesla was dat hun radar in de auto zo'n lage resolutie had.

Waymo kan nog niet met klanten op snelwegen rijden, deels vanwege het bereik van de LIDAR-sensoren en het afstemmen daarvan voor snel rijden. En vanwege het extra risico van hoge snelheden. Maar ze rijden nu daadwerkelijk op snelwegen zonder iemand op de bestuurdersstoel en laten werknemers ermee spelen. Dus ik denk niet dat het eerlijk is om te zeggen dat ze niet op snelwegen kunnen rijden, ze voelen zich gewoon nog niet comfortabel om klanten het te laten gebruiken.

Mijn favoriete argument waarom deep learning beter is dan een multi-sensorbenadering is dat de grootschalige dataset die je kunt opbouwen met een enkele goedkope sensormodaliteit extreem krachtig is voor het verhogen van de voorspellende nauwkeurigheid van het model. Je kunt al deze fancy sensoren hebben, maar als dat betekent dat je dataset een fractie van de grootte, diversiteit, enz. is, dan kan een alleen visiemodel in feite beter presteren in voorspellende nauwkeurigheid en dus veiligheid.

Ik ben het met hem eens dat alleen visie beter is, maar ik denk niet dat de kern daarvan sensorfusie is.

20,82K

Boven

Positie

Favorieten