Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

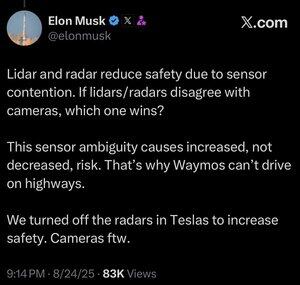

Mais dados nem sempre são melhores.

Quando um sistema automatizado precisa tomar uma decisão rapidamente, você deseja que ele tenha o conjunto mais enxuto possível de dados relevantes necessários para fazer a escolha correta.

Analisar mais coisas só o torna mais lento.

Você pode ver isso em humanos. O campo da inteligência artificial está sempre copiando o dever de casa da evolução, e por boas razões. Por que jogar fora todos esses milhões de anos de resultados emergentes e tentar começar de novo do zero?

Os humanos não têm realmente cinco sentidos (mais como cerca de 22), mas uma coisa que não vemos muito nesses sentidos é a sobreposição.

Parece que o processo evolutivo atingiu a noção, repetidas vezes, de que é melhor ajustar seus globos oculares para o que você precisa ver, em vez de desenvolver dois ou três tipos diferentes de globos oculares para olhar para a mesma coisa.

Claro, as abordagens multicanal não são impossíveis, e talvez um sistema somente lidar possa funcionar.

Mas o problema de usar câmeras análogas à visão humana é que você pode usar tudo o que sabemos sobre a visão humana.

E se você está usando isso para dirigir carros, então você tem o berço de cada coisa que sabemos ou podemos descobrir sobre como os humanos dirigem carros.

Se você é algum tipo de engenheiro, isso é óbvio e, apesar do que Lexxie possa pensar, ou fingir pensar enquanto as câmeras estão rodando, Elon Musk é todo engenheiro, 100% engenheiro e muito pouco mais, e qualquer outro engenheiro pode perceber isso apenas pela forma como ele fala.

O Lidar é bom para muitas coisas, provavelmente incluindo espaçonaves, mas quando você o coloca em um carro, é apenas uma admissão pública de que você não tem as habilidades, ou simplesmente não se preocupou, para desenvolver a capacidade de IA de apontar uma câmera para algo e realmente caracterizar o que você está olhando.

25 de ago., 13:59

Não tenho certeza se isso faz sentido. Concedido, Elon é muito mais inteligente do que eu, mas aqui estão meus 2 centavos:

Não acho que a fusão de sensores seja impossível, apenas torna o sistema muito mais complicado. Eu posso ver um objeto, tocá-lo, cheirá-lo, e meu cérebro pode fundir tudo isso naturalmente. Não acho que a fusão de sensores seja inerentemente menos segura, mas aumenta a complexidade do sistema e aumenta o número de pontos de falha. O principal problema da Tesla era que o radar do carro era de resolução muito baixa.

A Waymo ainda não pode dirigir em rodovias com clientes, em parte devido ao alcance dos sensores LIDAR e ao ajuste para direção em alta velocidade. E por causa do risco adicional de altas velocidades. Mas eles estão realmente correndo em rodovias agora sem ninguém no banco do motorista e deixando os funcionários brincarem com isso. Portanto, não acho justo dizer que eles não podem dirigir em rodovias, eles simplesmente não se sentem confortáveis em deixar os clientes usá-lo ainda.

Meu argumento favorito de por que o aprendizado profundo supera uma abordagem multissensor é que o conjunto de dados em grande escala que você pode construir com uma única modalidade de sensor de baixo custo é extremamente poderoso para aumentar a precisão preditiva do modelo. Você pode ter todos esses sensores sofisticados, mas se isso significa que seu conjunto de dados é uma fração do tamanho, diversidade, etc., um modelo somente de visão pode realmente superar em precisão preditiva e, portanto, segurança.

Concordo com ele que a visão só é melhor, mas não pense que o ponto crucial disso é a fusão de sensores

20,82K

Melhores

Classificação

Favoritos