热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

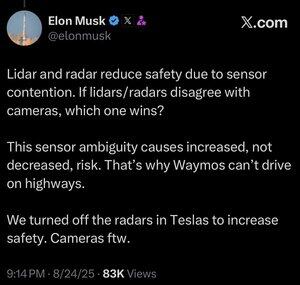

更多的数据并不总是更好。

当一个自动化系统需要快速做出决策时,你希望它拥有尽可能精简的相关数据集,以便做出正确的选择。

分析更多的东西只会让你变得更慢。

你可以在人类身上看到这一点。人工智能领域永远在模仿进化的作业,这有很好的理由。为什么要抛弃那些数百万年的涌现结果,试图从头开始。

人类实际上并没有五种感官(更像是22种),但在这些感官中,我们并不常见到重叠。

进化过程似乎一再强调,微调你的眼球以适应你需要看到的东西,比发展两三种不同类型的眼球来观察同一事物要好。

当然,多通道的方法并不是不可能的,也许可以让仅使用激光雷达的系统正常工作。

但使用与人类视觉相似的相机的好处在于,你可以借鉴我们对人类视觉的所有了解。

如果你用它来驾驶汽车,那么你就可以借鉴我们对人类如何驾驶汽车的所有了解或可以发现的知识。

如果你是任何类型的工程师,这都是显而易见的,尽管Lexxie可能会这样想,或者在摄像机录制时假装这样想,Elon Musk完全是工程师,100%是工程师,几乎没有其他身份,任何其他工程师都能从他的谈话中看出这一点。

激光雷达在许多方面都很好,可能包括航天器,但当你把它放在汽车上时,这只是公开承认你没有技能,或者只是没有努力去发展能够将相机指向某物并真正表征你所看到的东西的AI能力。

8月25日 13:59

我不确定这是否有意义。虽然埃隆比我聪明得多,但我想说说我的看法:

我认为传感器融合并不是不可能的,只是让系统变得更加复杂。我可以看到一个物体,触摸它,闻到它,我的大脑可以自然地将这些信息融合在一起。我认为传感器融合本质上并不更不安全,但它增加了系统的复杂性,并增加了故障点的数量。特斯拉的主要问题是他们的车载雷达分辨率太低。

Waymo目前还不能在高速公路上载客,部分原因是LIDAR传感器的范围以及为高速驾驶进行调校的难度。还有高速行驶带来的额外风险。但他们现在实际上在高速公路上运行,没有人坐在驾驶座上,让员工进行测试。所以我认为说他们不能在高速公路上行驶并不公平,他们只是还不觉得让客户使用它是安全的。

我最喜欢的论点是,深度学习胜过多传感器方法的原因在于,使用单一低成本传感器模态可以构建的大规模数据集对于提高模型的预测准确性极为强大。你可能拥有所有这些高级传感器,但如果这意味着你的数据集规模、种类等只是一个小部分,那么仅依靠视觉模型的预测准确性和安全性可能实际上会更高。

我同意他所说的仅依靠视觉更好,但我认为问题的关键并不在于传感器融合。

19.98K

热门

排行

收藏