Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

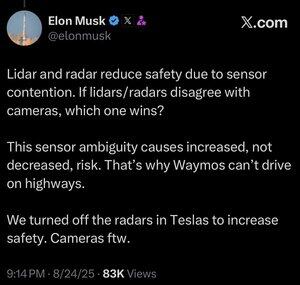

Mer data er ikke alltid bedre.

Når et automatisert system må ta en beslutning raskt, vil du at det skal ha et så slankt sett med relevante data som er nødvendig for å ta det riktige valget.

Å analysere flere ting gjør deg bare tregere.

Du kan se dette hos mennesker. Feltet kunstig intelligens kopierer alltid evolusjonens lekser, og med god grunn. Hvorfor kaste bort alle de millioner av år med nye resultater, og prøve å starte på nytt fra bunnen av.

Mennesker har faktisk ikke fem sanser (mer som omtrent 22), men en ting som vi ikke ser mye av i disse sansene er overlapping.

Det virker som om evolusjonsprosessen har truffet forestillingen, om og om igjen, at det er bedre å finjustere øyeeplene for det du trenger å se, i stedet for å utvikle to eller tre forskjellige typer øyeepler for å se på det samme.

Jada, flerkanalstilnærminger er ikke umulige, og kanskje et lidar-system kan få til å fungere.

Men greia med å bruke kameraer som er analoge med menneskelig syn, er at du får krybbe av hver eneste ting vi vet om menneskelig syn.

Og hvis du bruker det til å kjøre biler, så får du krybbe av hver eneste ting vi vet eller kan oppdage om hvordan mennesker kjører biler.

Hvis du er noen form for ingeniør i det hele tatt, er dette en no-brainer, og til tross for hva Lexxie kanskje tenker, eller later som om han tenker mens kameraene ruller, er Elon Musk ingeniør, 100 % ingeniør og veldig lite annet, og enhver annen ingeniør kan se dette bare fra hvordan han snakker.

Lidar er bra for mange ting, sannsynligvis inkludert romfartøy, men når du setter det i en bil, er det bare en offentlig innrømmelse av at du ikke har ferdighetene, eller bare ikke har brydd deg, til å utvikle AI-kapasiteten til å peke et kamera mot noe og virkelig karakterisere det du ser på.

25. aug., 13:59

Jeg er ikke sikker på at dette gir mening. Riktignok er Elon mye smartere enn meg, men her er mine 2 cent:

Jeg tror ikke sensorfusjon er umulig, det gjør bare systemet mye mer komplisert. Jeg kan se en gjenstand, ta på den, lukte den, og hjernen min kan smelte det sammen naturlig. Jeg tror ikke sensorfusjon i seg selv er mindre trygt, men det øker kompleksiteten til systemet og øker antall feilpunkter. Teslas hovedproblem var at radaren deres i bilen hadde så lav oppløsning.

Waymo kan ikke kjøre på motorveier med kunder ennå, delvis på grunn av rekkevidden til LIDAR-sensorene og tuning den for høyhastighetskjøring. Og på grunn av den ekstra risikoen for høye hastigheter. Men de kjører faktisk på motorveier nå uten noen i førersetet og lar ansatte leke med det. Så jeg tror ikke det er rettferdig å si at de ikke kan kjøre på motorveier, de føler seg bare ikke komfortable med å la kundene bruke den ennå.

Mitt favorittargument for hvorfor dyp læring slår en tilnærming med flere sensorer, er at det store datasettet du kan bygge med en enkelt lavkost sensormodalitet er ekstremt kraftig for å øke den prediktive nøyaktigheten til modellen. Du kan ha alle disse fancy sensorene, men hvis det betyr at datasettet ditt er en brøkdel av størrelsen, mangfoldet osv., kan en modell med kun visjon faktisk overgå prediktiv nøyaktighet og dermed sikkerhet.

Jeg er enig med ham i at synet bare er bedre, men tror ikke kjernen i det er sensorfusjon

18,37K

Topp

Rangering

Favoritter