Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

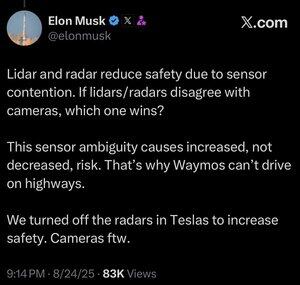

Mer data är inte alltid bättre.

När ett automatiserat system måste fatta ett beslut snabbt vill du att det ska ha en så smidig uppsättning relevanta data som möjligt för att göra rätt val.

Att analysera fler saker gör dig bara långsammare.

Du kan se detta hos människor. Området artificiell intelligens kopierar ständigt evolutionens läxor, och av goda skäl. Varför kasta bort alla dessa miljontals år av framväxande resultat och försöka börja om från början.

Människor har faktiskt inte fem sinnen (snarare cirka 22), men en sak som vi inte ser mycket av i dessa sinnen är överlappning.

Det verkar som om den evolutionära processen har träffat på idén, om och om igen, att det är bättre att finjustera dina ögonglober för vad du behöver se, snarare än att utveckla två eller tre olika typer av ögonglober för att titta på samma sak.

Visst, flerkanaliga tillvägagångssätt är inte omöjliga, och kanske kan ett system med endast lidar fås att fungera.

Men grejen med att använda kameror som är analoga med den mänskliga synen är att du får möjlighet att ta reda på allt vi vet om den mänskliga synen.

Och om du använder det för att köra bilar, då får du reda på varenda sak som vi vet eller kan upptäcka om hur människor kör bilar.

Om du är någon form av ingenjör överhuvudtaget är detta en no-brainer, och oavsett vad Lexxie kanske tror, eller låtsas tänka medan kamerorna rullar, är Elon Musk helt och hållet ingenjör, 100% ingenjör och väldigt lite annat, och alla andra ingenjörer kan upptäcka detta bara genom hur han pratar.

Lidar är bra för många saker, förmodligen inklusive rymdfarkoster, men när du sätter den i en bil är det bara ett offentligt erkännande att du inte har färdigheterna, eller bara inte har brytt dig, att utveckla AI-kapaciteten att rikta en kamera mot något och verkligen karakterisera det du tittar på.

25 aug. 13:59

Jag är inte säker på att det är vettigt. Visst, Elon är mycket smartare än mig, men här är mina 2 cent:

Jag tror inte att sensorfusion är omöjligt, det gör bara systemet mycket mer komplicerat. Jag kan se ett föremål, röra vid det, lukta på det, och min hjärna kan smälta samman det helt naturligt. Jag tror inte att sensorfusion i sig är mindre säkert, men det ökar komplexiteten i systemet och ökar antalet felpunkter. Teslas största problem var att deras radar i bilen var så lågupplöst.

Waymo kan inte köra på motorvägar med kunder ännu, delvis på grund av LIDAR-sensorernas räckvidd och inställningen för höghastighetskörning. Och på grund av den extra risken med höga hastigheter. Men de kör faktiskt på motorvägar nu utan någon i förarsätet och låter de anställda leka med det. Så jag tycker inte att det är rättvist att säga att de inte kan köra på motorvägar, de känner sig bara inte bekväma med att låta kunderna använda det ännu.

Mitt favoritargument för varför djupinlärning slår en metod med flera sensorer är att den storskaliga datamängden som du kan bygga med en enda sensormodalitet till låg kostnad är extremt kraftfull för att öka modellens prediktiva noggrannhet. Du kanske har alla dessa snygga sensorer, men om det innebär att din datauppsättning är en bråkdel av storleken, mångfalden osv. kan en modell med endast vision faktiskt överträffa i prediktiv noggrannhet och därmed säkerhet.

Jag håller med honom om att syn bara är bättre, men tror inte att kruxet med det är sensorfusion

20,83K

Topp

Rankning

Favoriter