Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

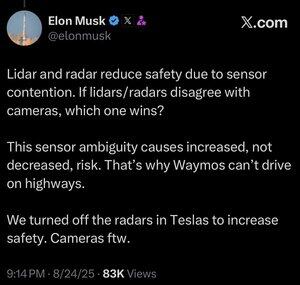

Więcej danych nie zawsze oznacza lepiej.

Kiedy zautomatyzowany system musi podjąć decyzję szybko, chcesz, aby miał jak najwęższy zestaw istotnych danych niezbędnych do podjęcia właściwego wyboru.

Analizowanie większej ilości rzeczy tylko spowalnia cię.

Możesz to zobaczyć u ludzi. Dziedzina sztucznej inteligencji nieustannie kopiuje zadania ewolucji, i to z dobrego powodu. Po co wyrzucać te miliony lat wyników ewolucyjnych i próbować zaczynać od zera?

Ludzie tak naprawdę nie mają pięciu zmysłów (raczej około 22), ale jedną rzeczą, której nie widzimy zbyt wiele w tych zmysłach, jest nakładanie się.

Wydaje się, że proces ewolucyjny wielokrotnie trafiał na pomysł, że lepiej jest dostosować swoje oczy do tego, co musisz zobaczyć, niż rozwijać dwa lub trzy różne rodzaje oczu do patrzenia na to samo.

Oczywiście, podejścia wielokanałowe nie są niemożliwe, a być może system oparty wyłącznie na lidarze mógłby działać.

Ale rzecz w tym, że używając kamer, które są analogiczne do ludzkiego wzroku, możesz korzystać z każdej rzeczy, którą wiemy o ludzkim widzeniu.

A jeśli używasz tego do prowadzenia samochodów, to możesz korzystać z każdej rzeczy, którą wiemy lub możemy odkryć o tym, jak ludzie prowadzą samochody.

Jeśli jesteś jakimkolwiek inżynierem, to jest to oczywiste, a mimo tego, co Lexxie może myśleć, lub udawać, że myśli, gdy kamery są włączone, Elon Musk to w pełni inżynier, 100% inżynier i bardzo mało czegoś innego, a każdy inny inżynier może to dostrzec tylko po tym, jak mówi.

Lidar jest dobry do wielu rzeczy, prawdopodobnie w tym do statków kosmicznych, ale kiedy umieszczasz go w samochodzie, to po prostu publiczne przyznanie, że nie masz umiejętności, lub po prostu nie chciałeś, aby rozwinąć zdolności AI do skierowania kamery na coś i naprawdę scharakteryzowania tego, co widzisz.

25 sie, 13:59

Nie jestem pewien, czy to ma sens. Owszem, Elon jest znacznie mądrzejszy ode mnie, ale oto moje 2 grosze:

Nie sądzę, że fuzja sensorów jest niemożliwa, po prostu sprawia, że system staje się znacznie bardziej skomplikowany. Widzę obiekt, dotykam go, czuję jego zapach, a mój mózg potrafi to wszystko naturalnie połączyć. Nie sądzę, że fuzja sensorów jest z natury mniej bezpieczna, ale zwiększa złożoność systemu i zwiększa liczbę punktów awarii. Głównym problemem Tesli było to, że ich radar w samochodzie miał tak niską rozdzielczość.

Waymo nie może jeszcze jeździć po autostradach z pasażerami, częściowo z powodu zasięgu czujników LIDAR i dostosowania ich do jazdy z dużą prędkością. A także z powodu dodatkowego ryzyka związanego z dużymi prędkościami. Ale teraz faktycznie jeżdżą po autostradach bez nikogo na miejscu kierowcy i pozwalają pracownikom bawić się tym. Więc nie sądzę, że sprawiedliwe jest mówienie, że nie mogą jeździć po autostradach, po prostu nie czują się jeszcze komfortowo, pozwalając klientom z tego korzystać.

Moim ulubionym argumentem na rzecz tego, dlaczego uczenie głębokie przewyższa podejście wielosensorowe, jest to, że duża skala zbioru danych, którą można zbudować za pomocą jednego taniego sensora, jest niezwykle potężna w zwiększaniu dokładności predykcyjnej modelu. Możesz mieć wszystkie te wymyślne czujniki, ale jeśli oznacza to, że twój zbiór danych jest ułamkiem rozmiaru, różnorodności itp., to model oparty tylko na wizji może w rzeczywistości przewyższyć pod względem dokładności predykcyjnej, a tym samym bezpieczeństwa.

Zgadzam się z nim, że wizja tylko jest lepsza, ale nie sądzę, że sedno sprawy tkwi w fuzji sensorów.

20,82K

Najlepsze

Ranking

Ulubione