Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

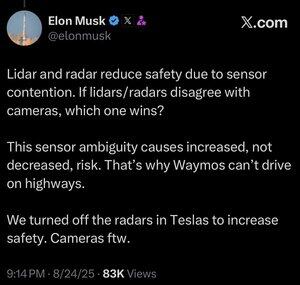

Più dati non significano sempre meglio.

Quando un sistema automatizzato deve prendere una decisione rapidamente, vuoi che abbia il set di dati rilevanti più snello possibile necessario per fare la scelta corretta.

Analizzare più cose ti rende solo più lento.

Puoi vedere questo negli esseri umani. Il campo dell'intelligenza artificiale copia per sempre i compiti dell'evoluzione, e per una buona ragione. Perché buttare via tutti quegli milioni di anni di risultati emergenti e cercare di ricominciare da zero?

Gli esseri umani non hanno effettivamente cinque sensi (più o meno circa 22), ma una cosa che non vediamo molto in quei sensi è la sovrapposizione.

Sembra che il processo evolutivo abbia colpito più e più volte il concetto che è meglio affinare i tuoi occhi per ciò che hai bisogno di vedere, piuttosto che sviluppare due o tre diversi tipi di occhi per guardare la stessa cosa.

Certo, approcci multi-canale non sono impossibili, e forse un sistema solo lidar potrebbe essere fatto funzionare.

Ma la cosa riguardo all'uso di telecamere che sono analoghe alla visione umana, è che puoi attingere a ogni singola cosa che sappiamo sulla visione umana.

E se stai usando questo per guidare auto, allora puoi attingere a ogni singola cosa che sappiamo o possiamo scoprire su come gli esseri umani guidano le auto.

Se sei un qualsiasi tipo di ingegnere, questo è un gioco da ragazzi, e, nonostante ciò che Lexxie potrebbe pensare, o fingere di pensare mentre le telecamere sono accese, Elon Musk è tutto ingegnere, 100% ingegnere e molto poco altro, e qualsiasi altro ingegnere può notarlo solo da come parla.

Il lidar è buono per molte cose, probabilmente incluso lo spazio, ma quando lo metti in un'auto, è solo un'ammissione pubblica che non hai le competenze, o semplicemente non ti sei preoccupato, di sviluppare la capacità di intelligenza artificiale per puntare una telecamera su qualcosa e caratterizzare davvero ciò che stai guardando.

25 ago, 13:59

Non sono sicuro che questo abbia senso. È vero che Elon è molto più intelligente di me, ma ecco il mio parere:

Non penso che la fusione dei sensori sia impossibile, rende solo il sistema molto più complicato. Posso vedere un oggetto, toccarlo, annusarlo, e il mio cervello può unire tutto questo in modo naturale. Non credo che la fusione dei sensori sia intrinsecamente meno sicura, ma aumenta la complessità del sistema e il numero di punti di guasto. Il principale problema di Tesla era che il radar a bordo era a bassa risoluzione.

Waymo non può ancora guidare in autostrada con i clienti, in parte a causa della portata dei sensori LIDAR e della loro regolazione per la guida ad alta velocità. E a causa del rischio aggiuntivo delle alte velocità. Ma ora stanno effettivamente circolando in autostrada senza nessuno al volante e permettendo ai dipendenti di sperimentare. Quindi non penso sia giusto dire che non possono guidare in autostrada, semplicemente non si sentono a proprio agio nel farlo utilizzare ai clienti ancora.

Il mio argomento preferito sul perché l'apprendimento profondo batte un approccio multi-sensore è che il grande dataset che puoi costruire con una singola modalità di sensore a basso costo è estremamente potente per aumentare l'accuratezza predittiva del modello. Puoi avere tutti questi sensori sofisticati, ma se significa che il tuo dataset è una frazione della dimensione, diversità, ecc., allora un modello solo visivo potrebbe effettivamente superare in accuratezza predittiva e quindi in sicurezza.

Sono d'accordo con lui che solo la visione è migliore, ma non penso che il nocciolo della questione sia la fusione dei sensori.

19,97K

Principali

Ranking

Preferiti